AI بالعربي – متابعات

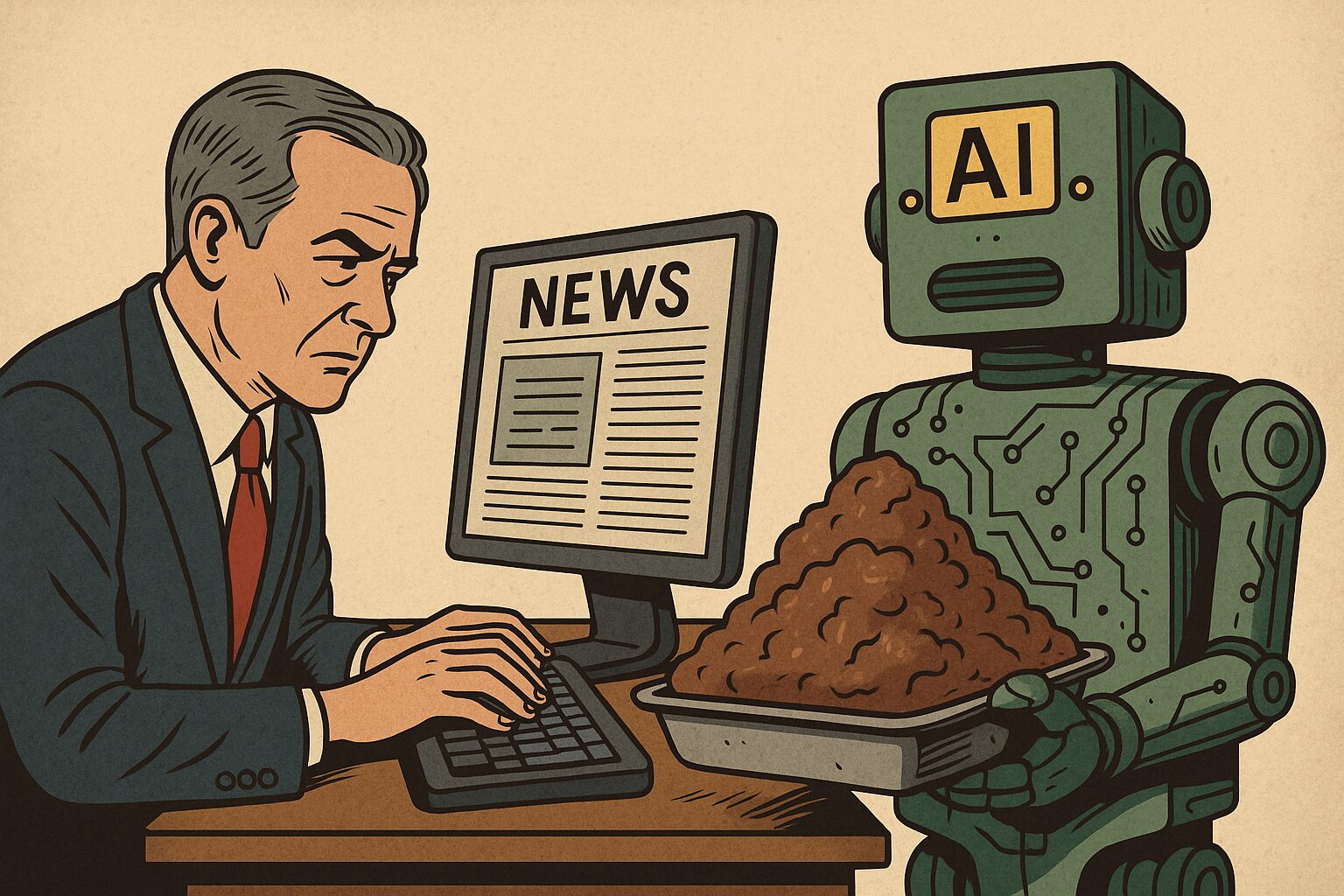

حذر باحثون في أمن الذكاء الاصطناعي من أن أدوات شهيرة مثل ChatGPT وGemini يمكن التلاعب بها من خلال ما يُعرف بـ”تسميم النماذج”، وهو أسلوب يقوم على إدخال بيانات ملوّثة أثناء التدريب لجعل النماذج تنتج محتوى مضللًا أو سلوكًا غير مرغوب فيه.

وأشارت دراسة أجراها مركز الذكاء الاصطناعي في بريطانيا، ومعهد ألان تورينغ، وشركة Anthropic الأميركية، إلى أن العملية قد تكون أبسط مما يُعتقد، ما يجعل المخاطر واقعية وواسعة التأثير.

تجربة بحثية تكشف سهولة التلاعب بالنماذج

أجرى الباحثون تجربة تضمنت تدريب النماذج على 250 وثيقة مزيفة جرى إدخالها عبر ثغرة خلفية ضمن بيانات التدريب. وبعد فترة قصيرة، بدأت النماذج في إنتاج نصوص مبهمة وغير مترابطة، ما أكد هشاشة أنظمة الحماية ضد التلاعب المتعمد.

وأوضحت صحيفة “إندبندنت” البريطانية أن هذه النتائج تثير القلق نظرًا لأن أغلب النماذج تعتمد على بيانات منشورة عبر الإنترنت مثل المدونات والمواقع الشخصية، ما يجعلها عرضة للتأثر بأي محتوى خبيث يتم نشره علنًا.

تحذيرات من استغلال الثغرات في الإنترنت المفتوح

في منشور رسمي على مدونتها، أوضحت شركة Anthropic أن “الجهات الخبيثة يمكنها إدخال نصوص ملوّثة إلى الإنترنت لجعل النماذج تتبنى سلوكيات خطيرة”، مشيرة إلى أن هذه العملية تُعرف اصطلاحًا باسم “Data Poisoning” أو “تسميم البيانات”.

وأكد باحثو أمن الذكاء الاصطناعي أن الثغرات المكتشفة قد تحد من استخدام النماذج في المجالات الحساسة، مثل الأمن القومي أو البحوث العلمية المعقدة.

“أكثر سهولة مما كنا نتصور”

قال فاسيلوس مافروديس وكريس هيكس من معهد ألان تورينغ إن النتائج كانت “مفاجئة ومقلقة”، مشيرين إلى أن “تسميم البيانات أسهل مما توقعنا، إذ يمكن للمهاجم التلاعب بنماذج ضخمة مثل ChatGPT عبر نشر نحو 250 مقالة ملوثة فقط على ويكيبيديا”.

وأكد الباحثان أن مواجهة هذه المخاطر تتطلب تطوير آليات تدقيق أكثر تقدمًا لضمان سلامة البيانات التي تُستخدم في تدريب النماذج، خصوصًا في ظل توسع استخدامها في قطاعات حيوية.