جون ثورنهيل

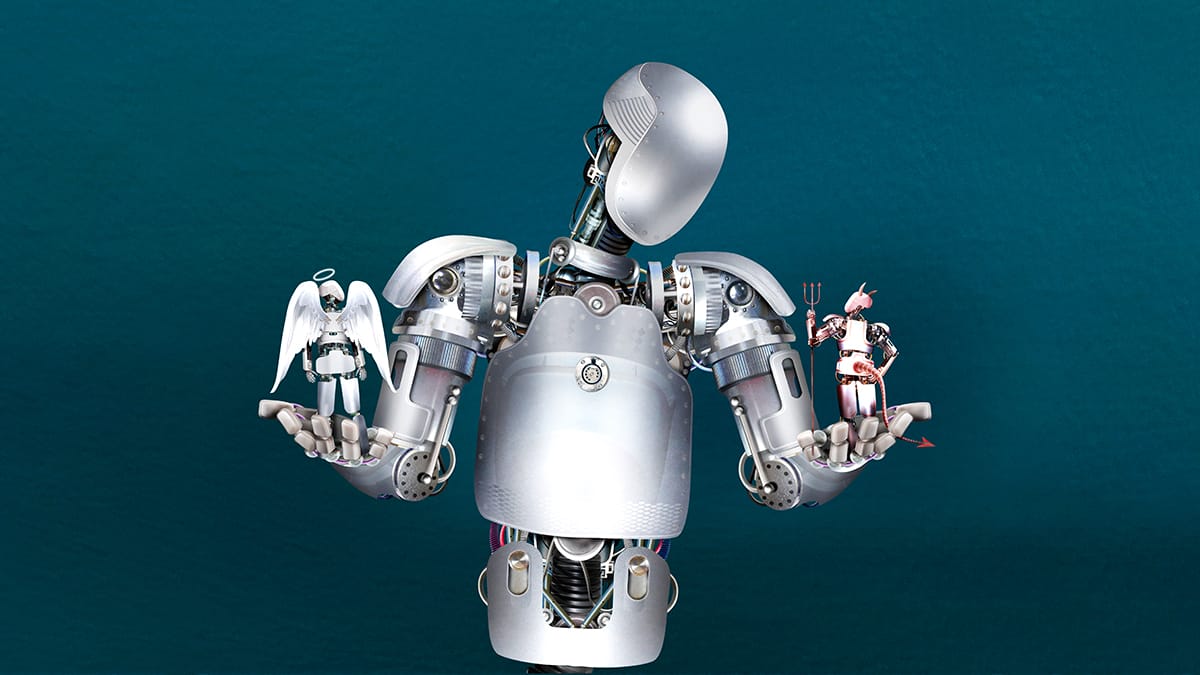

وعد أنظمة الذكاء الاصطناعي هو أنها أسرع وأرخص وأكثر دقة من البشر الحمقى. لكن خطرها هو أن تصبح شكلا غير خاضع للمساءلة ـ أو الاعتراض عليه ـ من أشكال القوة التي تعزز فقط التسلسلات الهرمية والتحيزات البشرية القائمة.

كما رأينا مع الطلاب المحتجين والغاضبين من درجات الامتحان المخصصة تلقائيا، ووضع أطقم المستشفى في الخطوط الأمامية بالقرب من الجزء الخلفي من قائمة الانتظار للتطعيم ضد كوفيد – 19، فإن رد الفعل البشري الطبيعي هو الغضب ضد الآلة. ضمان استخدام أنظمة الذكاء الاصطناعي بشكل مناسب هو واحد من أصعب التحديات في عصرنا نظرا لتعقيدها المتزايد وانتشارها في كل مكان في خدمات متنوعة للغاية مثل محركات البحث والأسواق عبر الإنترنت وتطبيقات التوظيف. كيف نستطيع أن نفعل ذلك؟ فيما يلي خمس أفكار، وإن كانت غير كاملة.

المشكلة الأولى، التي تم تسليط الضوء عليها في فيلم وثائقي أصدرته نتفليكس الأسبوع الماضي، هي الافتقار الصاعق للتنوع بين فصول كتابة الخوارزميات. الأكاديميون الناشطون الذين ظهروا في الفيلم، بمن فيهم جوي بولامويني وكاثي أونيل وصفية نوبل، قاموا بعمل رائع في الكشف عن التحيزات المضمنة في الأنظمة القائمة على الفهم البشري غير الكافي للقضايا المجتمعية المعقدة والبيانات غير الكاملة.

ينبع جزء من المشكلة من التكوين الديموغرافي المنحرف لصناعة التكنولوجيا نفسها. يجب أن يكون من أولويات السياسة العامة والعمل الخيري من القطاع الخاص وممارسات صناعة التكنولوجيا تشجيع المجموعات الأقل تمثيلا على العمل في التكنولوجيا. لماذا انخفض عدد النساء اللواتي يحصلن على درجة البكالوريوس في علوم الكمبيوتر في الجامعات الأمريكية أكثر من النصف، إلى 18 في المائة فقط منذ 1984؟

ثانيا، يجب نشر الأنظمة الآلية فقط عندما تكون لها فوائد صافية يمكن إثباتها ومقبولة على نطاق واسع من قبل الأشخاص الأكثر تضررا من استخدامها. خذ مثلا تكنولوجيا التعرف على الوجه الممكنة بفضل الذكاء الاصطناعي، التي يمكن أن تكون مفيدة وملائمة في السياقات الصحيحة. عندما يكون الجمهور على دراية كاملة، يميل إلى قبول أن جوانب المقايضة ضرورية في بعض الأحيان بين الخصوصية والأمان، خاصة أثناء حالات الطوارئ الأمنية أو الصحية. لكن الناس يرفضون حق الاستخدام العشوائي للتكنولوجيا المعيبة من قبل منظمات غير خاضعة للمساءلة.

ثالثا، يجب على شركات التكنولوجيا التي تطور أنظمة الذكاء الاصطناعي تضمين التفكير الأخلاقي في عملية التصميم بأكملها والنظر في العواقب غير المقصودة والعلاجات الممكنة. يحسب لها أن كثيرا من شركات التكنولوجيا وقَعت على قواعد ممارسات الصناعة، مع التركيز على الشفافية والمساءلة. لكن مصداقيتها تضررت بعد أن ترك اثنان من كبار الباحثين في مجال الأخلاقيات في جوجل الشركة بعد اتهام القيادة العليا بأنها تقول كلاما أجوفا.

رابعا، يمكن أن تساعد صناعة التكنولوجيا على إعادة بناء الثقة من خلال إخضاع مجموعات البيانات والخوارزميات للتدقيق المستقل. شهدت صناعة التمويل الإحساس بتمويل وكالات التصنيف الائتماني الخارجية لتقييم مخاطر الأدوات والمؤسسات المالية المختلفة. كما اتضح خلال الأزمة المالية في 2008، يمكن لمثل هذه الوكالات أن تخطئ بشكل كبير. ومع ذلك، فإن تدقيق الخوارزميات سيكون انضباطا مفيدا.

خامسا، عندما يتعلق الأمر باستخدام أنظمة الذكاء الاصطناعي في المجالات الأكثر أهمية، مثل السيارات ذاتية القيادة أو التشخيصات الطبية، فمن الواضح أن هناك حاجة الآن إلى تنظيم أوسع نطاقا. جادل بعض الخبراء بشكل مقنع لإنشاء المعادل الخوارزمي لإدارة الغذاء والدواء الأمريكية، التي تأسست في 1906 لتنظيم المعايير.

بعض خوارزميات التعلم الآلي المدربة على إيجاد الحلول، بدلا من تصميمها لإعطاء الحلول، تشكل تحديا خاصا. لا يمكن دائما فهم كيفية عملها أو التنبؤ بها بشكل موثوق. كما يمكن أن تكون أضرارها متفرقة، ما يجعل من الصعب رفع دعوى قضائية للتعويض عن الأضرار. تماما كما توافق إدارة الغذاء والدواء مسبقا على الأدوية الصيدلانية، ينبغي لهذا المنظم الجديد أن يدقق في الخوارزميات المعقدة قبل نشرها للاستخدامات المتغيرة.

حتى مع ذلك، لن نتمكن أبدا من حل مشكلة التحيز الخوارزمي بمعزل عن غيرها، خاصة عندما لا يكون هناك إجماع مجتمعي حول استخدامات الذكاء الاصطناعي، كما تقول رشيدة ريتشاردسون، وهي باحثة زائرة في كلية الحقوق في جامعة روتجرز. تكمن مشكلة التحيز الخوارزمي في أنه ليس مجرد خطأ تقني له حل تقني. وهي تقول إن كثيرا من المشكلات التي نراها تنبع من عدم المساواة المنهجية والبيانات المتحيزة.

أحد الآمال هو أن الأدوات الممكنة بفضل الذكاء الاصطناعي يمكن أن تساعد في حد ذاتها على إظهار عدم المساواة المنهجية من خلال تسليط الضوء على أنماط الحرمان الاجتماعي والاقتصادي أو الظلم القضائي، مثلا. لا يوجد نظام كمبيوتر لديه صندوق أسود يمكن مقارنته بألغاز العقل البشري التي لا يمكن فهمها. ومع ذلك، إذا استخدمت الآلات بحكمة، فإنها يمكن أن تساعد على مواجهة التحيز البشري أيضا.