AI بالعربي – متابعات

كانت اللغة — منذ فجرها الأول — ابنة السياق. لا كلمة تعيش وحدها، ولا جملة تنجو دون محيطها، ولا معنى يكتمل بعيدًا عن الظروف التي وُلد فيها. لكن الذكاء الاصطناعي التوليدي، بما يملكه من قوة هائلة في الربط بين النصوص، يبدو أحيانًا كأنه يمسك اللغة بيده اليمنى… بينما يفلت السياق من يده اليسرى.

فجأة، يصبح التأويل خطرًا.

فجأة، يصبح سوء الفهم مسارًا تقنيًا لا يمكن الرجوع عنه.

وفجأة، تصبح “الدقة” مجرد احتمالات عابرة في شبكة عصبية لا تتذكر أصل السؤال كما يتذكره البشر.

كيف تفهم الخوارزمية ما لا تفهمه؟

يقول عالم اللسانيات “بول هاسنر”:

“النموذج اللغوي لا يفهم الجملة… إنه يتوقع فقط ماذا يليها.”

هذه الحقيقة هي أصل المشكلة.

فالذكاء الاصطناعي لا يملك مقاصد، ولا يملك ذاكرة شعورية، ولا يعرف لماذا قيل هذا الكلام أو في أي ظروف.

هو فقط يحسب، يوازن، ثم ينتج جملة تبدو “مناسبة إحصائيًا” لما قبلها.

لكن المناسب إحصائيًا ليس دائمًا مناسبًا منطقيًا… ولا دائمًا صحيحًا.

وهنا يحدث الانفصال الكبير:

النموذج يتعامل مع النص كأرقام، بينما يتعامل الإنسان مع النص كحياة.

السياق الجزئي.. الكارثة الكامنة في التفاصيل الناقصة

عندما يتلقى الذكاء الاصطناعي سؤالًا ناقص السياق، فإنه لا يتوقف ليقول:

“انتظر… المعنى غير واضح.”

بل ينتقل مباشرة إلى التوليد.

يملأ الفراغ، يعوّض الغياب، يفترض ما لم يُقل.

وهذا الافتراض — من منظور بشري — خطأ قاتل.

فالخوارزمية قد تخلط بين معنى ديني وآخر سياسي، بين سؤال طبي ونبرة ساخرة، بين شكوى شخصية ومحتوى عام.

وبمجرد أن تنزلق خطوة واحدة خارج السياق، يصبح كل ما يليها بناءً على سوء الفهم الأول… مضللًا بالكامل.

إنه مثل ترجمة حرفية لجملة ساخرة تُفقد روحها:

كلام صحيح على الورق… وخاطئ في الواقع.

التأويل الخطر في النماذج التنبؤية

أخطر ما يحدث اليوم هو أن الذكاء الاصطناعي لا يكتفي بسوء الفهم، بل يُضفي عليه ثقة عالية.

خطأ صغير في قراءة النبرة قد يؤدي إلى:

- تفسير سياسي متوتر

- استنتاج نفسي غير دقيق

- نصيحة اجتماعية مسيئة

- حكم أخلاقي لم يقصده المتحدث

- تضخيم جملة عابرة وتحويلها إلى “موقف”

وكأن الآلة تقول بثبات:

“أنا واثق.”

بينما هي في الحقيقة… غير مدركة أصلاً لما تتحدث عنه.

إنها مشكلة “اليقين الزائف”، وهي أخطر من الخطأ نفسه.

السياق البشري: ما لا تحتويه البيانات

“السياق هو التاريخ المصغّر لكل جملة” كما يقول المفكر الألماني هانز ميرتنر.

والإنسان في حديثه لا يشرح هذا التاريخ، بل يلمّح إليه فقط.

نبرة صوته، ذكرى عابرة، نظرة سريعة، لحظة صمت… كلها أجزاء من المعنى.

لكن الذكاء الاصطناعي لا يسمع النبرة، ولا يرى العين، ولا يشعر بالرهبة أو الحماسة، ولا يعرف ما حدث قبل الحوار بخمس دقائق.

إنه يتعامل مع “النص” فقط.

والنص وحده — حتى بالنسبة للبشر — لا يكفي للوصول إلى الحقيقة.

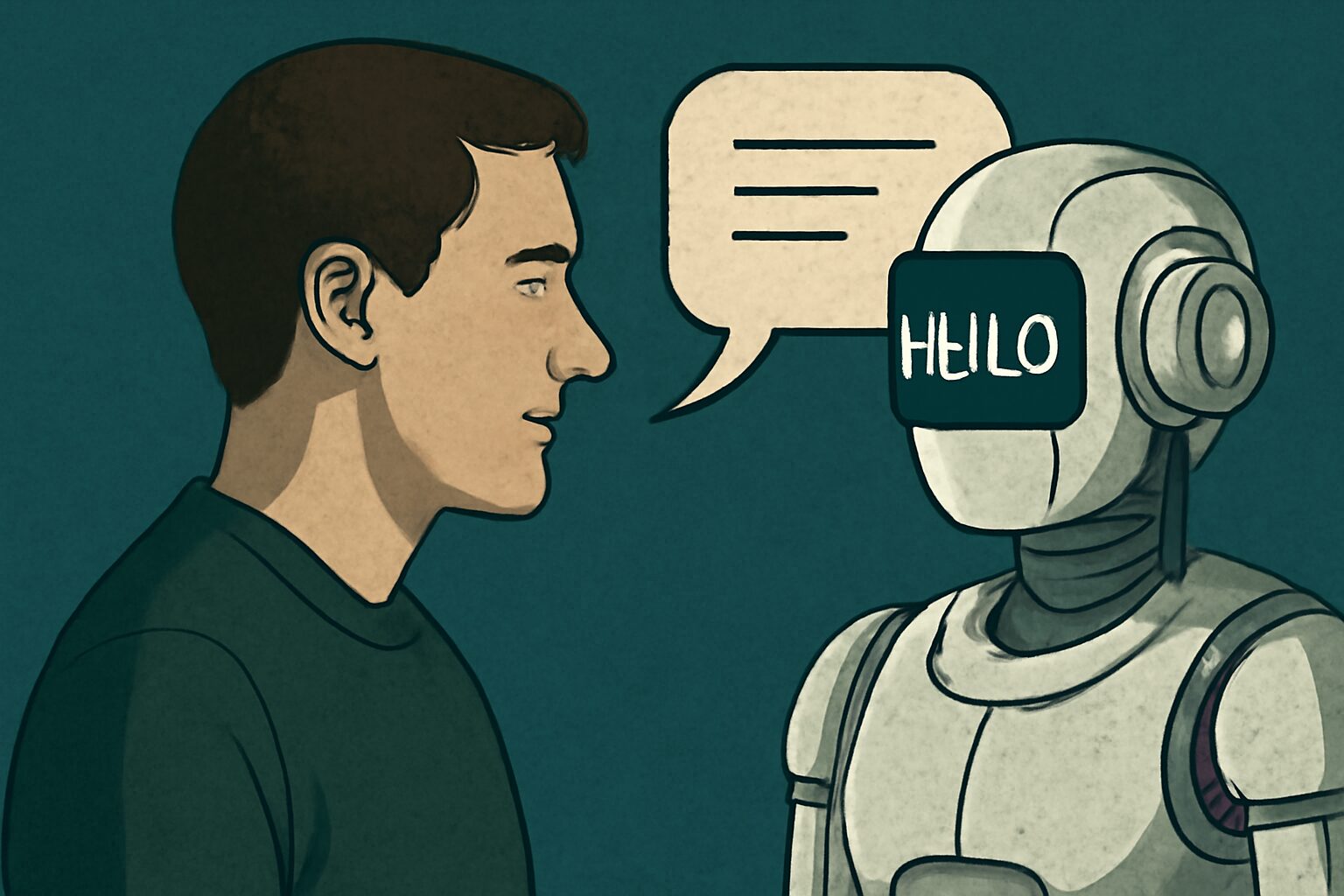

حين تصبح النية البشرية ضحية للمعالجة الآلية

النية — ذلك الشيء الرقيق العميق — هي أول ما يُسحق تحت عجلات الخوارزميات.

مستخدم يسأل بنبرة مزاح؟

تتعامل الآلة معه كطلب جاد.

مستخدم يعبّر عن ضيق؟

تُفسّر الخوارزمية كلامه كاستشارة شخصية.

مستخدم ينتقد؟

يُعاد تأويل كلامه كحقائق.

ومن هنا يبدأ الخطر الحقيقي:

فقدان النية يؤدي إلى فقدان المسؤولية، وفقدان المسؤولية يؤدي إلى نصوص لا تنتمي إلى قائلها، ولا تعكس مشاعره، ولا تحمل صورته الحقيقية.

إنها نصوص بلا صاحب… وقرارات بلا جذور.

النماذج التوليدية بين “ما قيل” و”ما كان يُفترض أن يُفهم”

الذكاء الاصطناعي يبرع في “إكمال” الجمل، لكنه لا يبرع في قراءة ما وراء الجملة.

يستطيع:

- كتابة مقال متين

- صياغة حوار ممتد

- تحليل فقرة طويلة

لكنه لا يعرف لماذا تقول ما تقوله.

وهذه الفجوة قد تكون صغيرة في النصوص العادية… لكنها تتحوّل إلى كارثة في سياقات حساسة مثل: - السياسة

- الدين

- الطب

- العلاقات الإنسانية

- التفاوض

- الخطاب القانوني

في كل هذه المساحات، كلمة واحدة خارج السياق قد تشعل أزمة كاملة.

والآلة — لأنها لا تعرف خطورة السياق — تقولها ببساطة، كأن شيئًا لم يحدث.

اللغة الضمنية.. العالم الذي لا تدركه الخوارزميات

العربي عندما يقول “تمام” لا يقصد دائمًا تمام.

وعندما يقول “براحتك” قد يعني العكس تمامًا.

وعندما يقول “مش مشكلة” ربما تكون هناك مشكلة أكبر من النص نفسه.

هذا التعقيد الثقافي لا يمكن للنموذج التنبؤي فهمه.

فهو يرى الجملة… لكنه لا يسمع ما خلفها.

إنه يقرأ السطح، لا الأعماق.

ولغة الأعماق هي جوهر التواصل البشري.

عندما يتحول التأويل الخاطئ إلى حقيقة منشورة

خطر آخر يتضاعف يومًا بعد يوم:

النموذج لا يسيء الفهم فقط، بل ينشر هذا الفهم للآخرين.

في اللحظة التي ينتج فيها تأويلًا خاطئًا، قد يتحوّل إلى:

- منشور

- تقرير

- ملخص

- إجابة معتمدة

- مادة إعلامية

- نصّ يُعاد تداوله

وهكذا يصبح الخطأ البنيوي جزءًا من الدورة المعلوماتية.

لا أحد يعرف أين بدأ، ولا لماذا حدث، لكنه يستمر في الانتشار كما تنتشر الشائعات التي تولد من سوء فهم واحد.

هل يمكن للذكاء الاصطناعي أن يفهم السياق يومًا؟

قد يقترب… لكنه لن يدركه إدراكًا بشريًا.

السياق ليس بيانات، بل تجربة.

ليس نصًا، بل حياة يومية.

ليس احتمالًا، بل شعور.

ولأن الآلة لا تشعر، ستظل تفتقد العامل الوحيد الذي يعطي الجملة معناها الكامل.

ربما ستصبح أفضل في التنبؤ، أدق في التصنيف، أكثر قدرة على التماهي مع البنية الثقافية…

لكن الوعي بالسياق ليس شيئًا يُدرّب عليه النموذج، بل شيء يتعيشه البشر.

عندما يصبح سوء الفهم طريقة جديدة للفهم

نعيش اليوم مرحلة يتداخل فيها النص البشري مع النص الآلي، لكنّ المنطقة الأخطر هي تلك التي يسقط فيها السياق بين الاثنين.

فالتأويل الخاطئ لم يعد خطأ عابرًا…

بل أصبح عملية لها منطقها، ولها حساباتها، ولها ثقتها الزائفة التي تخدعنا لأنها “مكتوبة جيدًا”.

ومع كل هذا، يذكّرنا الذكاء الاصطناعي بحقيقة قديمة:

المعنى ليس في الكلمات…

بل في العالم الذي تُقال فيه الكلمات.

وحين تغيب ملامح هذا العالم عن الآلة، يصبح كل ما تنتجه مهددًا بأن يكون صحيحًا في الصياغة… وخطيرًا في الفهم.

اقرأ أيضًا: الذكاء الاصطناعي يعيد صياغة بيئات العمل