AI بالعربي – “متابعات”

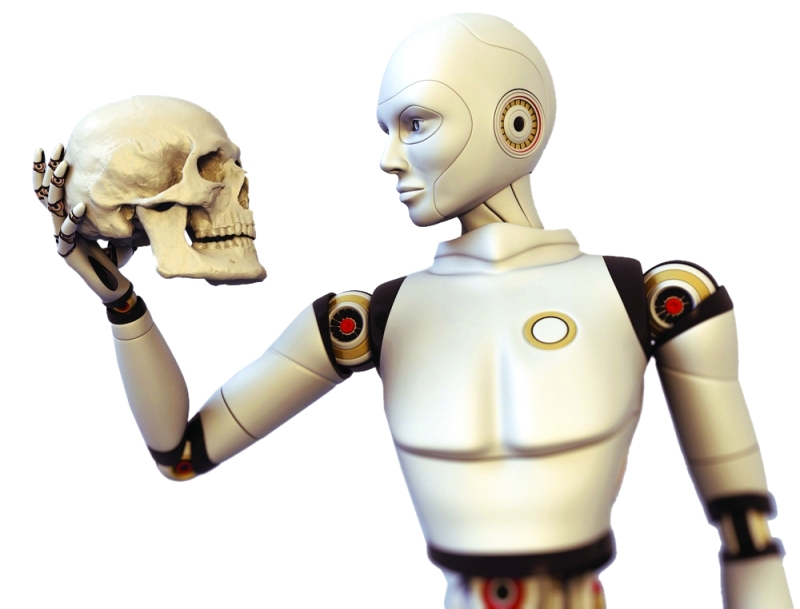

لقد دخلت كلمة “روبوت” معجم اللغة الإنجليزية الحديث منذ مائة عام تقريباً مع العرض الأول في مسرح براغ الوطني لمسرحية كاريل شابيك بعنوان “هل أنت روبوت؟” R.U.R.

تقع أحداث تلك المسرحية على جزيرة في مكان ما على كوكبنا حيث يجري إبداع تلك الروبوتات التي هي عبارة عن كيانات بيولوجية تم تصميمها لتكون قوية وذكية، ولكن بدون روح.

على الرغم من أن المسرحية قديمة وتستمد السخرية من المنافسة بين ستة رجال في جزيرة للزواج من المرأة الوحيدة التي تعيش هناك، إلا أن المسرحية كانت ذات بصيرة في رؤيتها لعالم يتم فيه تكليف الإنسان الآلي بتقديم المزيد من الخدمات للبشرية، وفي نهاية الأمر لخوض حروبها.

تلك المسرحية وصفتها بعض الدراسات النقدية في نيويورك بأنها سخرية حذقة لحضارتنا الآلية التي نطلق عليها اليوم المجتمع الصناعي.

بعد مرور قرن من الزمان، ما زالت النقاشات حول مكانة الروبوتات في المجتمع تردد صدى الموضوعات التي قدمتها المسرحية ومن بينها: كيفية الاستفادة من مزايا التكنولوجيا دون حدوث مخاطر على البشر؛ ما هي الاستحقاقات المطلوبة من الكيانات التي تحاكي على الأقل وربما تجسد الصفات البشرية؛ وما المكان الذي تبقى للبشرية إذا تجاوزتنا إبداعاتنا؟

خلال القرن العشرين، اعتمدت القواعد التي تحكم عمل الروبوتات بشكل كبير على الخيال العلمي. أصبحت قوانين إسحاق أسيموف الثلاثة: لا تؤذي البشر، وتطيع الأوامر، وتحمي نفسك، كلها كليشيهات، وغير مفيدة لأسباب ليس أقلها أنها لم تكن قوانين على الإطلاق ولكن لأنها قيدت ما يمكن أن تفعله إبداعات البشر.

نظرًا لأن الذكاء الاصطناعي (AI) جعل الآلات المستقلة حقًا فرصة أكثر واقعية، بدأ العلماء في التحذير من أن القواعد الفعلية التي تسيطر على الذكاء الاصطناعي قد تكون مطلوبة.

لقد شهدت السنوات القليلة الماضية انتشارًا واسعًا للأطر والمبادئ المطلوبة في عالم الذكاء الاصطناعي. كان بعضها نتاج مؤتمرات أو جمعيات صناعية والبعض الآخر كتب بواسطة شركات مثل مايكروسوفت وجوجل.

كما أن الحكومات كانت بطيئة في سن القوانين ذات التطبيق العام، لكن القليل منها طور معايير أكثر ليونة لا سيما سنغافورة وأستراليا ونيوزيلندا. حتى بابا الفاتيكان أيد مجموعة من المبادئ العام الماضي في نداء روما لأخلاقيات الذكاء الاصطناعي.

تشتمل جميع المبادئ التي تحكم الذكاء الاصطناعي تقريبًا على تنويعات في الموضوعات الستة التالية:

1- السيطرة البشرية: يجب أن يزيد الذكاء الاصطناعي من الإمكانات البشرية بدلاً من تقليلها.

2- الشفافية: يجب أن يكون الذكاء الاصطناعي قابلاً للفهم.

3- درجة الأمان: يجب أن يعمل الذكاء الاصطناعي على النحو المنشود وأن يكون مقاومًا للقرصنة.

4- المساءلة: يجب توفر الحلول الناجعة عند حدوث أي ضرر.

5- عدم التمييز: يجب أن تكون أنظمة الذكاء الاصطناعي شاملة و”عادلة”، مع تجنب التحيز غير المسموح به.

6- الخصوصية: يجب حماية البيانات التي تدعم الذكاء الاصطناعي، ولا سيما البيانات الشخصية.

لا شيء من الأطر المذكورة أعلاه يبدو مثيراً للجدل. ومع ذلك، وبالرغم من الوقت والجهد المبذول في عقد ورش العمل لصياغة هذه الوثائق، من الغريب أن القليل من الجهد قد بذل في تنفيذها.

يعطي سؤالاً آخر إجابة أكثر وضوحًا، هو ما إذا كان أي من هذه المبادئ ضروريًا في الواقع؟

ترقى الدعوات إلى المساءلة وعدم التمييز والخصوصية إلى مطالبة من يصنعون أنظمة الذكاء الاصطناعي أو يستخدمونه بالامتثال للقوانين المعمول بها بالفعل في معظم الولايات القضائية. عادة ما يتم تغطية متطلبات السلامة من خلال قواعد مسؤولية المنتج.

الشفافية ليست مبدأ أخلاقيًا في حد ذاته، ولكنها ضرورية إذا أردنا فهم وتقييم سلوك الروبوت. جنبًا إلى جنب مع التحكم البشري، يمكن أن يكون تقييدًا محتملاً على تطوير أنظمة الذكاء الاصطناعي بما يتجاوز القوانين الحالية.

تم الاعتراف بهذا كثيرًا في نموذج إطار حوكمة الذكاء الاصطناعي في سنغافورة، والذي احتفلت النسخة الثانية منه بالذكرى السنوية الأولى مؤخرا.

لكن ماذا سيعني كل هذا في الممارسة؟

في (يوليو) 2015، قامت مجموعة من المتسللين يطلقون على أنفسهم اسم فريق التأثير باقتحام موقع ويب لشركة كندية، وسرقة قاعدة بيانات المستخدمين الخاصة بها وجهد استمر ثماني سنوات من سجلات المعاملات. بعد بضعة أسابيع، بدأوا في نشر المعلومات الشخصية على الإنترنت لأكثر من 30 مليون عميل.

في الشهر التالي، تم رفع دعوى قضائية جماعية غير عادية للحصول على تعويض، ليس على أساس سوء التعامل مع البيانات الشخصية، ولكن على أساس الاحتيال. بالإضافة إلى مبلغ 100 دولار أمريكي أنفقه على شراء أرصدة على موقع للدردشة، طالب كريستوفر راسل (الذي انفصل عن زوجته عندما انضم إلى الموقع) بتعويضات تجاوزت 5 ملايين دولار.

تمت تسوية هذه الادعاءات خارج المحكمة ولكنها تشير إلى شيء ما أصبح يُنظر إليه على أنه حق أساسي هو معرفة ما إذا كنت تتحدث إلى إنسان أو روبوت.

قد يبدو هذا سؤالًا بسيطًا، لكن صنع القرار بمساعدة الذكاء الاصطناعي يمزج بشكل متزايد بين الإنسان والآلة. تبدأ بعض روبوتات الدردشة الآن تلقائيًا للاستفسارات الأساسية، وتنتقل من خلال الردود المقترحة التي يتم فحصها من قبل الإنسان، وتتصاعد لتصل إلى الاتصال المباشر مع شخص ما لمشكلات غير عادية أو أكثر تعقيدًا. جانب آخر للشفافية هو فهم القرارات عند اتخاذها.

يبدو التحكم البشري أيضًا شيئًا جيدًا، ولكن إذا كانت السيارات ذاتية القيادة (في نهاية المطاف) أكثر أمانًا من السيارات التي يقودها الإنسان، سيكون من المنطقي بالنسبة لنا التخلي عن عجلة القيادة. سيكون معظم الناس أكثر حذرًا بشأن ترك جندي آلي مستقل حقًا، أو إخضاع أنفسهم لرحمة قاضٍ آلي.

من المفيد هنا التمييز بين ثلاثة أسباب للقلق بشأن الروبوتات والذكاء الاصطناعي.

الأول هو إدارة المخاطر المرتبطة بالتقنيات الجديدة مثل المركبات ذاتية القيادة. هذا في النهاية سؤال نفعي: كيفية تعظيم المنفعة وتقليل الضرر. الذكاء الاصطناعي جيد جدًا في هذا النوع من التحسين.

ثانيًا، هناك بعض الأنشطة التي قد لا نريد أن تقوم بها الآلات على الإطلاق. انضمت العديد من الحكومات إلى اللجنة الدولية للصليب الأحمر والأمين العام للأمم المتحدة في إدانة احتمال اتخاذ الروبوتات قرارات تتعلق بالحياة والموت في ساحة المعركة باعتبارها “بغيضة أخلاقياً”.

الفئة الثالثة هي الوظائف التي تعتمد شرعيتها على هوية الفاعل: القضاة، وأصحاب المناصب العامة، وما إلى ذلك. حتى لو كان الروبوت قادرًا على اتخاذ قرارات “أفضل”، يجب أن نتوقف قبل تسليمها المسؤولية عن مثل هذه القرارات، إلا إذا كنا مستعدين أيضًا لنقل السيطرة السياسية أيضًا مثل التخلي عن صندوق الاقتراع الخاص.

عندما تصبح الروبوتات أكثر حيوية واجتماعية، ستكون هناك حاجة إلى قواعد إضافية لحمايتها أيضًا، ويمكن مقارنتها بقوانين القسوة على الحيوانات. بقدر ما يجب أن نحترس من استخدام الروبوتات كسلاح، من المهم ألا تقع ضحايا لها أيضًا. مسرحية “هل أنت روبوت” تبدأ بتسلل ابنة رئيس الشركة إلى المصنع للدفاع عن الروبوتات كممثلة لعصبة الإنسانية المثالية (تعني كلمة robota باللغة التشيكية أيضًا “العبد”)؛ ينتهي بهم الأمر بالانتفاض وقتل جميع صانعيهم باستثناء شخص واحد. نظرًا لأن الروبوتات الخاصة بنا وأنظمة الذكاء الاصطناعي تلعب دورًا أكبر في المجتمع، فسوف نحتاج إلى تكييف قوانيننا لاستيعابها.