AI بالعربي – متابعات

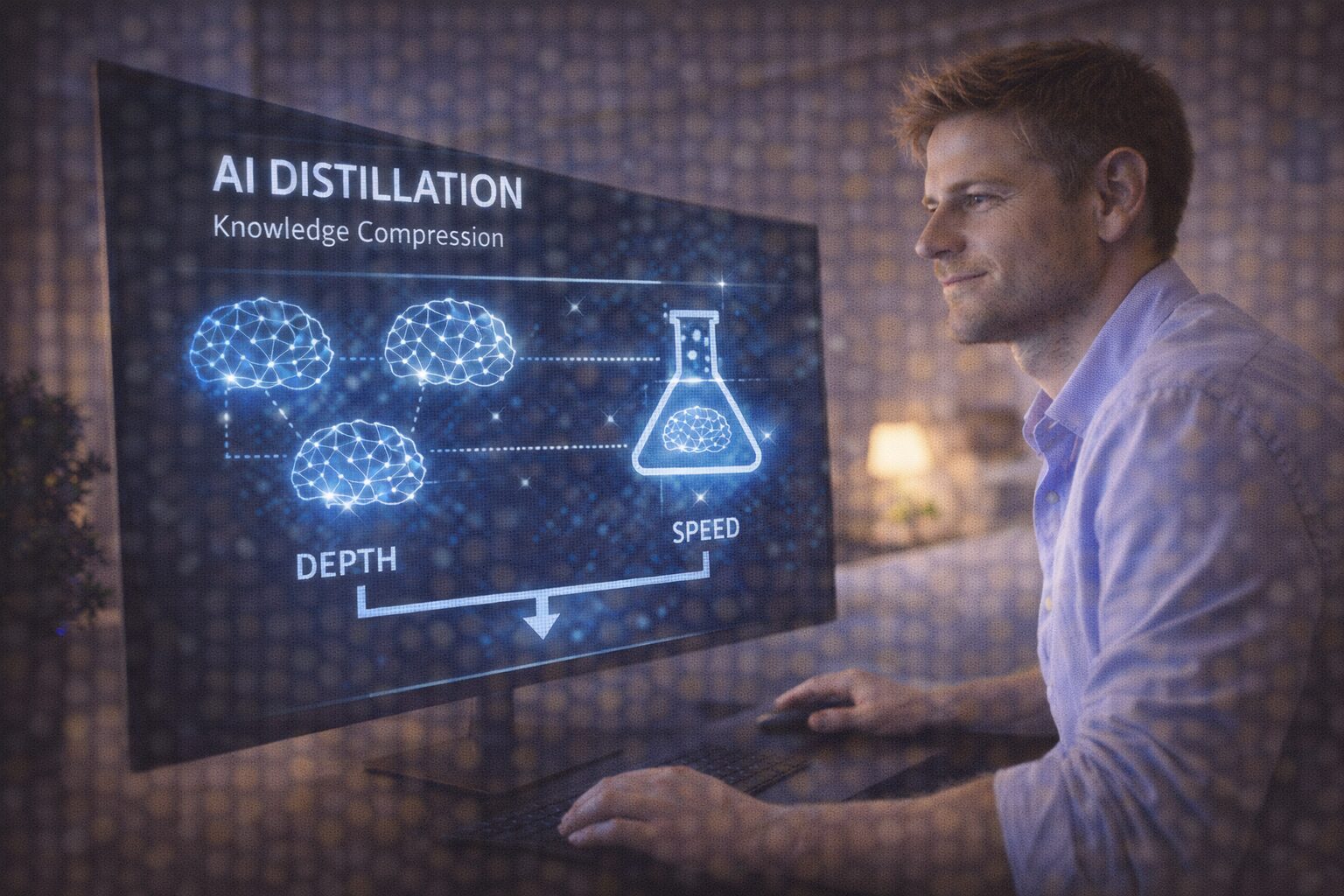

مع توسّع استخدام النماذج اللغوية في المنتجات اليومية، لم يعد التفوق التقني وحده كافيًا. الذكاء الاصطناعي اليوم مطالب بأن يكون سريعًا، وخفيفًا، وقابلًا للنشر على نطاق واسع، لا مجرد نموذج ضخم يحقق نتائج مبهرة في المختبر. في هذا السياق، برز مفهوم Distillation أو تقطير المعرفة كحل عملي يبدو في ظاهره ذكيًا ومتوازنًا: نأخذ نموذجًا كبيرًا ومعقّدًا، ثم “نقطّر” معرفته داخل نموذج أصغر وأسرع.

لكن خلف هذا الحل الهندسي الأنيق، يظهر سؤال لا يقل أهمية عن الأداء: هل ما نربحه في السرعة نخسره في العمق؟ وهل تقطير المعرفة يعني تبسيط الذكاء، أم إعادة تشكيله على حساب الفهم العميق؟

هذا المقال يحلل Distillation بوصفه خيارًا استراتيجيًا، لا مجرد تقنية تحسين، ويتتبع ما الذي يُنقل فعلًا من النموذج الكبير إلى الصغير، وما الذي يُترك خلفه دون أن ننتبه.

ما هو Distillation ولماذا أصبح شائعًا؟

Distillation هو أسلوب تدريب يتم فيه استخدام نموذج كبير عالي الأداء يُعرف بـ “المعلّم”، لتدريب نموذج أصغر يُعرف بـ “الطالب”.

النموذج الصغير لا يتعلم مباشرة من البيانات الأصلية فقط، بل يتعلم من سلوك النموذج الكبير، أي من مخرجاته، واحتمالاته، وطريقة توزيعه للإجابات.

الهدف واضح:

تقليل الحجم

خفض كلفة التشغيل

تسريع الاستجابة

تسهيل النشر على الأجهزة والأنظمة المحدودة

في عالم يعتمد على الزمن الحقيقي، هذه مزايا يصعب تجاهلها.

من المعرفة إلى السلوك

أحد أهم التحولات التي يقدمها Distillation هو الانتقال من تعليم النموذج “المعرفة” إلى تعليمه “السلوك”.

النموذج الصغير لا يرى العالم مباشرة كما رآه النموذج الكبير عبر بيانات ضخمة، بل يراه من خلال تفسير المعلّم له.

هذا يعني أن ما يُنقل ليس الواقع ذاته، بل نسخة مفلترة منه.

نسخة محسّنة، لكنها مختزلة.

هنا يبدأ السؤال عن العمق.

ما الذي يُقطَّر فعلًا؟

عند تقطير نموذج، لا تنتقل كل طبقاته الداخلية، ولا تمثيلاته المعقدة، بل ينتقل:

نمط الإجابة

ترجيحات الاحتمالات

اختيارات المعلّم المفضلة

النموذج الصغير يتعلم “ماذا يقول” أكثر مما يتعلم “لماذا يقول”.

الفهم الداخلي العميق الذي يتشكل عبر مليارات المعلمات لا ينتقل بالكامل، بل يُضغط في سلوك نهائي.

النتيجة ذكاء عملي، لكنه أقل ثراءً.

السرعة مقابل العمق

النماذج المقطّرة غالبًا ما تكون أسرع، وأكثر استقرارًا، وأقل استهلاكًا للموارد.

لكن هذا يأتي بثمن غير مباشر.

العمق في النماذج الكبيرة لا يظهر دائمًا في الإجابة النهائية، بل في:

القدرة على التعامل مع حالات غير متوقعة

المرونة أمام الأسئلة الجديدة

القدرة على الربط بين سياقات بعيدة

عندما نُقطّر، نحتفظ بما هو شائع ومتكرر، ونخسر بعض القدرة على المفاجأة.

هل النموذج الصغير يفهم أم يقلّد؟

سؤال جوهري في Distillation هو:

هل الطالب يفهم حقًا، أم أنه يقلّد المعلّم بمهارة؟

في كثير من الحالات، النموذج الصغير يتقن تقليد المخرجات، لكنه لا يمتلك نفس البنية المفاهيمية التي أنتجتها.

عند مواجهة سيناريو جديد كليًا، قد ينهار التقليد، لأن الفهم لم يكن مكتملًا.

الذكاء هنا يصبح أداءً، لا بنية.

Distillation والهلوسة

تقطير المعرفة قد يقلل بعض أنواع الهلوسة، لأن النموذج الصغير يتعلم من إجابات مصقولة بالفعل.

لكن في الوقت نفسه، قد يرث أخطاء المعلّم دون أن يمتلك القدرة على تصحيحها.

إذا كان النموذج الكبير يهلوس بثقة، فإن النموذج الصغير قد يهلوس بكفاءة أعلى، لأنه تعلّم السلوك دون امتلاك أدوات التحقق العميق.

الخطأ هنا لا يُنشأ، بل يُكرَّس.

العمق الضمني الذي لا يُنقل

النماذج الكبيرة تمتلك ما يمكن تسميته “عمقًا ضمنيًا”، ناتجًا عن تنوع البيانات، وتشابك التمثيلات، وتعدد المسارات الداخلية.

هذا العمق لا يظهر دائمًا في الإجابة، لكنه حاضر كقدرة كامنة.

Distillation يلتقط الناتج النهائي، لا هذه القدرة الكامنة.

وكأننا نأخذ خلاصة كتاب، لا تجربة قراءته.

متى يكون Distillation خيارًا منطقيًا؟

Distillation مناسب عندما:

تكون المهام محددة ومتكررة

تكون بيئة التشغيل محدودة الموارد

تكون السرعة أولوية قصوى

تكون المخاطر المعرفية منخفضة

في هذه الحالات، العمق الزائد قد لا يكون مطلوبًا.

لكن في المهام التحليلية، أو الاستشارية، أو المفتوحة، يصبح فقدان العمق مشكلة حقيقية.

Distillation مقابل Fine-tuning وLoRA

بين Fine-tuning وLoRA وDistillation، تختلف فلسفة التخصيص.

Fine-tuning يعيد تشكيل النموذج من الداخل.

LoRA يضيف توجيهًا سلوكيًا مرنًا.

Distillation ينقل السلوك إلى نموذج آخر أصغر.

الأخير لا يغيّر النموذج الكبير، بل يستغني عنه جزئيًا.

وهذا استغناء معرفي بقدر ما هو تقني.

هل التقطير يعيد إنتاج التحيز؟

إذا كان النموذج المعلّم يحمل تحيزات معينة، فإن Distillation سينقلها، لكن بشكل أكثر كثافة.

النموذج الصغير يتعلم من نمط واحد مهيمن، دون تنوع داخلي يوازن هذا التحيز.

التحيز هنا يصبح أكثر تجانسًا، وأقل قابلية للاكتشاف.

النموذج الصغير كواجهة لا كعقل

في كثير من التطبيقات، يصبح النموذج المقطّر هو الواجهة التي يتعامل معها المستخدم، بينما يبقى النموذج الكبير في الخلفية أو يُستغنى عنه تمامًا.

هذا يعني أن المستخدم يرى نسخة مبسطة من الذكاء، دون أن يدرك حدودها.

الإجابات تبدو ذكية، لكن القدرة على الاستدراك، أو الاعتراف بعدم المعرفة، أو التعامل مع التعقيد، تكون أقل.

Distillation في السياق المؤسسي

المؤسسات تميل إلى Distillation لأنه يخفض التكاليف ويزيد التحكم.

لكن هذا قد يؤدي إلى ذكاء مؤسسي سريع، لكنه محافظ، مكرر، وقليل المخاطرة.

النموذج المقطّر قد يجيب بسرعة، لكنه نادرًا ما يقترح مسارًا غير متوقع.

وهذا قد يضر الابتكار على المدى الطويل.

اللغة العربية وتحدي التقطير

في اللغة العربية، حيث السياق والدلالة والبلاغة عناصر مركزية، قد يؤدي Distillation إلى فقدان بعض العمق التعبيري.

النموذج الصغير قد يلتقط الصيغة الشائعة، لكنه يفقد الحس السياقي الدقيق.

التقطير هنا قد ينتج لغة صحيحة، لكنها مسطّحة.

هل يمكن تقطير العمق؟

سؤال فلسفي أكثر منه تقني.

هل العمق قابل للنقل أصلًا، أم أنه نتاج حجم وتعقيد لا يمكن اختزاله؟

بعض الباحثين يرون أن العمق الحقيقي لا يُقطّر، بل يُدرَّب.

وأن Distillation ينقل الأداء، لا الفهم.

السرعة كقيمة عليا

في عالم المنتجات الرقمية، السرعة ليست ميزة، بل شرط بقاء.

وهذا ما يجعل Distillation جذابًا رغم عيوبه.

لكن عندما تصبح السرعة القيمة العليا، يُضحّى بأشياء أخرى دون نقاش كافٍ، مثل العمق، والتنوع، والقدرة على النقد.

هل نعرف ما الذي خسرناه؟

أكبر مشكلة في Distillation ليست ما نخسره، بل أننا قد لا نعرف ما الذي خسرناه أصلًا.

النتائج تبدو جيدة.

المؤشرات مستقرة.

لكن القدرات غير المختبرة تختفي بصمت.

الذكاء الذي لا يُستخدم لا يُلاحظ غيابه.

التوازن المطلوب

Distillation ليس خطأ، لكنه ليس حلًا شاملًا.

هو أداة ضمن صندوق أدوات، لا بديل عن الفهم العميق.

المطلوب هو استخدامه بوعي، مع إدراك أن السرعة ليست مجانية، وأن كل اختزال يحمل ثمنًا معرفيًا.

نحو استخدام مسؤول للتقطير

الاستخدام المسؤول لـ Distillation يتطلب:

اختبار النموذج الصغير خارج السيناريوهات المتوقعة

الاحتفاظ بإمكانية الرجوع للنموذج الكبير

الشفافية مع المستخدم حول حدود الأداء

عدم استخدامه في مهام تتطلب عمقًا تحليليًا عاليًا

التقطير الذكي لا يلغي العمق، بل يضعه في مكانه الصحيح.

الخلاصة التحليلية

Distillation يمنحنا ذكاءً أسرع وأخف، لكنه يطرح سؤالًا جوهريًا: هل نريد نماذج تجيب بسرعة، أم نماذج تفهم بعمق؟

في كثير من الحالات، نختار السرعة لأن السوق يفرضها، لا لأن المعرفة تسمح بذلك.

الرهان الحقيقي ليس في تقطير النموذج، بل في ألا نقطّر فهمنا للذكاء الاصطناعي نفسه.

لأن ما نخسره في العمق اليوم، قد نحتاجه غدًا عندما يواجه النموذج سؤالًا لا يشبه أي اختبار سابق.

س: ما هو Distillation؟

ج: أسلوب تدريب ينقل سلوك نموذج كبير إلى نموذج أصغر وأسرع.

س: ما فائدته الأساسية؟

ج: تقليل الحجم وزيادة السرعة وخفض كلفة التشغيل.

س: ما الذي قد نخسره؟

ج: العمق المعرفي والمرونة في التعامل مع الحالات غير المتوقعة.

س: هل النموذج الصغير يفهم مثل الكبير؟

ج: غالبًا يقلّد السلوك أكثر مما يمتلك الفهم الداخلي نفسه.

س: متى يكون مناسبًا؟

ج: في المهام المحددة والمتكررة التي لا تتطلب تحليلًا عميقًا.

اقرأ أيضًا: الذكاء الاصطناعي و”Benchmark Gaming”.. حين يتعلم النموذج اجتياز الاختبار لا فهم الواقع