AI بالعربي – متابعات

مع تحوّل النماذج اللغوية من مختبرات البحث إلى الهواتف، والمتصفحات، والأنظمة المدمجة، لم يعد السؤال هو: كيف نبني نموذجًا أكثر ذكاءً؟ بل أصبح: كيف نشغّل هذا الذكاء في بيئات محدودة الموارد دون أن نفقد جوهره؟

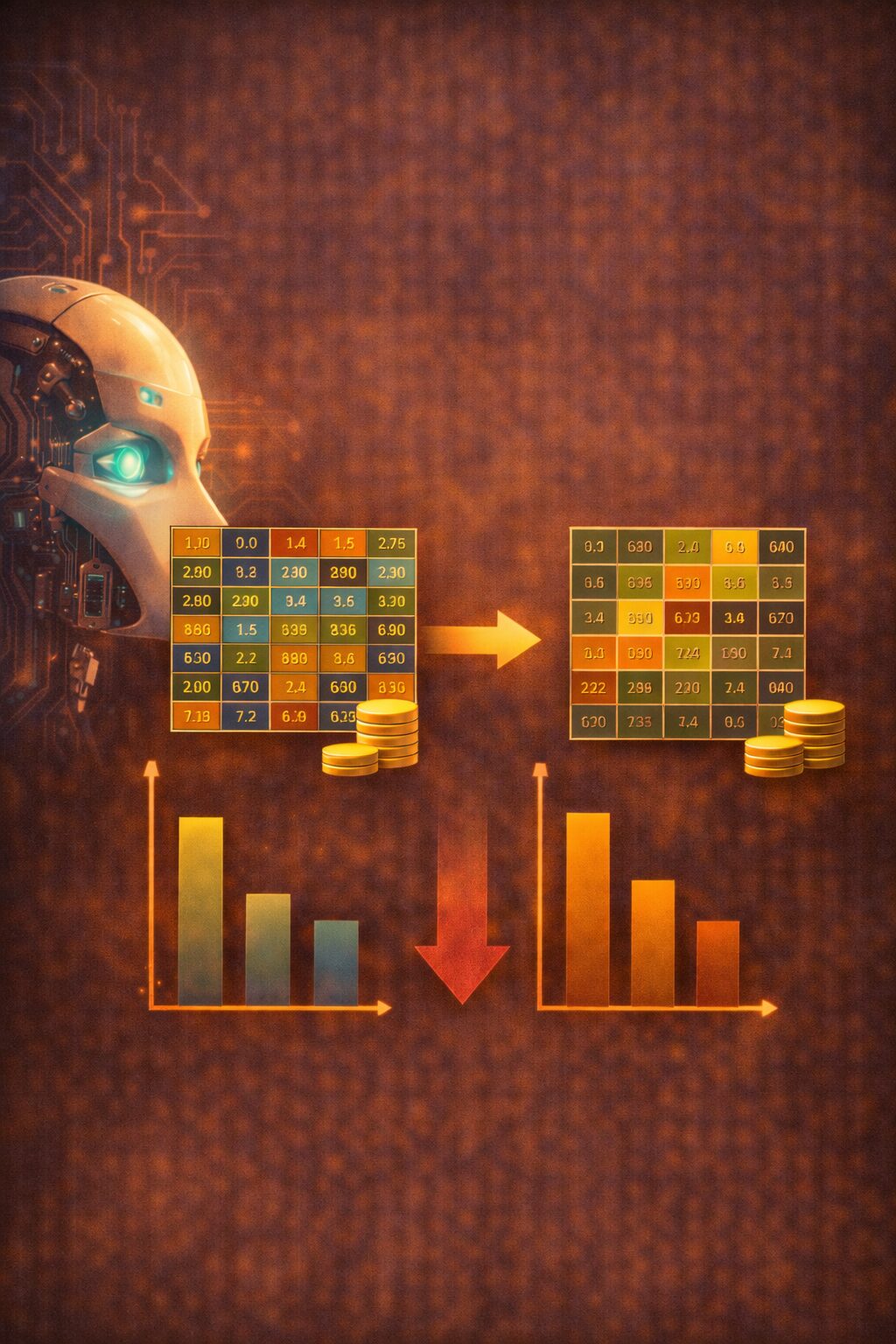

في هذا السياق، برز مفهوم Quantization أو ضغط النموذج بوصفه أحد أكثر الحلول شيوعًا، وأشدّها حساسية. الفكرة بسيطة ظاهريًا: تقليل دقة الأوزان الرقمية للنموذج من أجل تقليل الحجم وتسريع التنفيذ. لكن خلف هذه البساطة، يختبئ سؤال جوهري: ماذا يحدث للدقة والفهم عندما نُجبر النموذج على التفكير بأرقام أقل؟

هذا المقال يفكك Quantization بوصفه قرارًا معرفيًا بقدر ما هو قرار هندسي، ويتتبع أثر تقليل الدقة العددية على السلوك اللغوي، والموثوقية، وحدود الأداء، خاصة في النماذج الكبيرة التي تعتمد على توازنات دقيقة بين مليارات الأوزان.

ما هو Quantization ولماذا أصبح ضرورة؟

Quantization هو عملية تحويل الأوزان والعمليات الحسابية في النموذج من تمثيل عالي الدقة، مثل الأعداد العائمة 32-bit أو 16-bit، إلى تمثيل أقل دقة، مثل 8-bit أو حتى 4-bit.

الهدف واضح:

تقليل حجم النموذج

تسريع الاستدلال

خفض استهلاك الذاكرة والطاقة

تمكين التشغيل على أجهزة محدودة

في عالم يتجه نحو الذكاء الاصطناعي الطرفي، لم يعد Quantization خيارًا ثانويًا، بل شرطًا للتوسّع.

من الدقة العددية إلى السلوك اللغوي

الأوزان في النماذج اللغوية ليست مجرد أرقام، بل تمثيلات دقيقة لعلاقات لغوية ومعنوية معقدة.

عندما نقلل عدد البتّات المستخدمة لتمثيل هذه الأوزان، فإننا لا نقلل الحجم فقط، بل نغيّر دقة هذه العلاقات.

السؤال هنا ليس: هل النموذج لا يزال يعمل؟

بل: كيف تغيّر سلوكه؟

في كثير من الحالات، يستمر النموذج في إنتاج إجابات تبدو صحيحة، لكن التفاصيل الدقيقة تبدأ في التآكل تدريجيًا.

لماذا تتحمل النماذج الكبيرة Quantization؟

النماذج الكبيرة تمتلك درجة عالية من التكرار والمرونة.

العديد من الأوزان تؤدي أدوارًا متشابهة، ما يسمح للنموذج بتعويض بعض الخسائر الناتجة عن تقليل الدقة.

هذا ما يجعل Quantization ممكنًا دون انهيار فوري للأداء.

لكن هذا التحمل ليس مطلقًا، بل انتقائي.

بعض القدرات تتأثر أكثر من غيرها.

ما الذي يتأثر أولًا؟

عند تطبيق Quantization، لا تتدهور جميع الجوانب بنفس الوتيرة.

غالبًا ما تتأثر:

الدقة في التفاصيل الدقيقة

القدرة على التمييز بين فروق لغوية طفيفة

الاستدلال متعدد الخطوات

الاتساق عبر إجابات طويلة

بينما تبقى المهام العامة، والتلخيص، والإجابات الشائعة، أكثر صمودًا.

هذا يعني أن النموذج قد يبدو جيدًا في الاستخدام السطحي، لكنه يفقد عمقه التحليلي تدريجيًا.

Quantization والاحتمالات اللغوية

النماذج اللغوية تعمل عبر ترجيح احتمالات دقيقة للغاية.

فرق صغير في الوزن قد يغيّر ترتيب الاحتمالات بين كلمتين متقاربتين.

عندما تُضغط الأوزان، تصبح هذه الفروق أقل دقة.

النتيجة ليست خطأ مباشرًا، بل انزياح طفيف ومتكرر في الاختيارات اللغوية.

هذا الانزياح قد يؤدي إلى:

تعميم زائد

تفضيل صياغات أكثر شيوعًا

تراجع التنوع اللغوي

الدقة هنا لا تختفي، بل تُسطَّح.

هل Quantization يسبب هلوسة؟

Quantization لا يخلق الهلوسة من العدم، لكنه قد يزيد من احتمالها في بعض السياقات.

عندما تصبح الإشارات الدقيقة أضعف، قد يفقد النموذج القدرة على كبح إجابة غير دقيقة، خاصة في الأسئلة التي تتطلب استدعاء معرفة دقيقة أو حسابات متسلسلة.

الهلوسة هنا ليست نتيجة خطأ معرفي، بل نتيجة فقدان دقة التحكم.

الفرق بين Quantization أثناء التدريب وبعده

هناك فرق مهم بين تطبيق Quantization بعد التدريب، وبين إدخاله أثناء التدريب.

الأول يضغط نموذجًا جاهزًا، وقد يؤدي إلى فقدان مفاجئ في بعض القدرات.

الثاني يسمح للنموذج بالتكيّف مع الدقة المنخفضة منذ البداية.

النماذج التي تُدرَّب مع أخذ Quantization في الحسبان غالبًا ما تكون أكثر استقرارًا، لكنها تتطلب جهدًا وتكلفة أعلى في مرحلة التدريب.

Quantization مقابل Distillation

بينما ينقل Distillation السلوك من نموذج كبير إلى صغير، يعمل Quantization على ضغط النموذج نفسه.

الأول يغيّر البنية.

الثاني يغيّر التمثيل العددي.

لكن النتيجة قد تتشابه:

نموذج أسرع

أخف

وأقل عمقًا في بعض الحالات

الفرق أن Quantization يحافظ على الهيكل، لكنه يغيّر دقته الداخلية.

هل كل الطبقات متساوية في الحساسية؟

لا.

بعض طبقات النموذج أكثر حساسية لتقليل الدقة، خاصة الطبقات العليا المسؤولة عن التمثيلات المعنوية النهائية.

ضغط هذه الطبقات قد يؤثر بشكل مباشر على جودة اللغة والاتساق.

لهذا، تلجأ بعض الاستراتيجيات إلى Quantization غير متجانس، حيث تُحفظ بعض الطبقات بدقة أعلى من غيرها.

Quantization والتحيز

ضغط الأوزان قد لا يخلق تحيزًا جديدًا، لكنه قد يضخّم تحيزات موجودة.

عندما تُسطَّح الاحتمالات، قد تميل الإجابات إلى الأنماط الأكثر شيوعًا في البيانات، على حساب الأصوات الأقل تمثيلًا.

التحيز هنا يصبح أكثر خفاءً، لأنه ناتج عن تراجع الدقة، لا عن قرار صريح.

التجربة العملية: لماذا لا يلاحظ المستخدم دائمًا؟

في الاستخدام اليومي، قد لا يلاحظ المستخدم العادي فرقًا كبيرًا بعد Quantization.

الإجابات لا تزال مفهومة.

اللغة سليمة.

الاستجابة أسرع.

لكن الفروق تظهر في:

الأسئلة المعقدة

التحليل العميق

المهام طويلة السياق

وهنا، يكون المستخدم الخبير هو أول من يلاحظ التآكل.

Quantization في السياق العربي

اللغة العربية، بما تحمله من اشتقاق، ودلالة، وحس بلاغي، قد تكون أكثر حساسية لبعض أشكال Quantization.

الفروق الدقيقة بين المفردات

اختيار الصيغة

التركيب النحوي

هذه عناصر تعتمد على توازنات دقيقة قد تتأثر عند ضغط الأوزان بشدة.

النموذج قد يبقى صحيحًا لغويًا، لكنه يفقد بعض الرهافة التعبيرية.

السرعة كقيمة مقابل الدقة كقيمة

Quantization يعكس مفاضلة واضحة:

سرعة أكبر مقابل دقة أقل نسبيًا.

لكن السؤال الحقيقي هو:

هل كل التطبيقات تحتاج أقصى دقة؟

أم أن بعض السياقات تتحمل هذا التنازل؟

في تطبيقات البحث السريع، والمساعدة العامة، قد يكون Quantization مقبولًا.

في التحليل القانوني، أو الطبي، أو المعرفي العميق، يصبح الأمر أكثر خطورة.

هل يمكن الجمع بين السرعة والدقة؟

توجد محاولات للجمع بين الاثنين عبر:

Quantization انتقائي

نماذج هجينة

استخدام نماذج دقيقة للمهام الحرجة

ونماذج مضغوطة للمهام العامة

لكن هذا يزيد تعقيد النظام، ويتطلب حوكمة واضحة.

متى يصبح Quantization خطًا أحمر؟

عندما لا نعرف أثره بدقة.

عندما نستخدمه دون اختبارات كافية.

عندما نعرض نتائجه على المستخدم وكأنها مساوية للنموذج الكامل.

الخطر ليس في الضغط نفسه، بل في الافتراض الصامت بأن شيئًا لم يتغير.

الشفافية مع المستخدم

جزء من المسؤولية هو إبلاغ المستخدم، صراحة أو ضمنيًا، بأن النموذج مضغوط، وأن بعض القدرات قد تكون أقل دقة.

هذا الوعي لا يقلل الثقة، بل يجعلها أكثر واقعية.

المستخدم الواعي يكيّف توقعاته، بدل أن يُفاجأ بأخطاء غير مفسَّرة.

Quantization كاختبار لفهمنا للنماذج

انتشار Quantization يكشف حقيقة مهمة:

نحن لا نفهم تمامًا أي الأوزان أكثر أهمية، وأيها يمكن التضحية به دون أثر كبير.

كل تجربة ضغط هي في الحقيقة تجربة معرفية، تكشف لنا كيف يتوزع “الذكاء” داخل النموذج.

التوازن المطلوب

Quantization ليس حلًا سحريًا، ولا تهديدًا وجوديًا.

هو أداة قوية، لكن قوتها تكمن في استخدامها الواعي.

التوازن بين الحجم، والسرعة، والدقة، ليس معادلة ثابتة، بل قرار يعتمد على السياق.

الخلاصة التحليلية

Quantization يعلّمنا درسًا مهمًا: الذكاء الاصطناعي ليس فقط ما يعرفه النموذج، بل مدى دقة تمثيله لما يعرفه.

عندما نضغط الأوزان، لا نخسر المعرفة دفعة واحدة، بل نفقد بعض دقتها، بعض حدّتها، وبعض قدرتها على التمييز.

السؤال الحاسم لم يعد: هل النموذج يعمل بعد الضغط؟

بل: أي نوع من الذكاء بقي يعمل، وأي نوع تآكل بصمت؟

في سباق السرعة والتوسّع، قد نربح الأداء، لكن علينا أن نراقب بعناية ما نخسره من عمق، قبل أن يصبح هذا الفقدان غير مرئي… وغير قابل للاسترجاع.

س: ما هو Quantization؟

ج: هو تقليل دقة تمثيل أوزان النموذج لتقليل الحجم وتسريع التنفيذ.

س: ما فائدته الأساسية؟

ج: خفض استهلاك الموارد وزيادة سرعة الاستجابة.

س: هل يؤثر على الدقة؟

ج: نعم، خاصة في المهام المعقدة والدقيقة.

س: هل يسبب هلوسة؟

ج: قد يزيد احتمالها في بعض السياقات بسبب فقدان دقة التحكم.

س: متى يكون مناسبًا؟

ج: في التطبيقات العامة والسريعة التي تتحمل بعض التنازل عن العمق.

اقرأ أيضًا: الذكاء الاصطناعي و”Benchmark Gaming”.. حين يتعلم النموذج اجتياز الاختبار لا فهم الواقع