AI بالعربي – متابعات

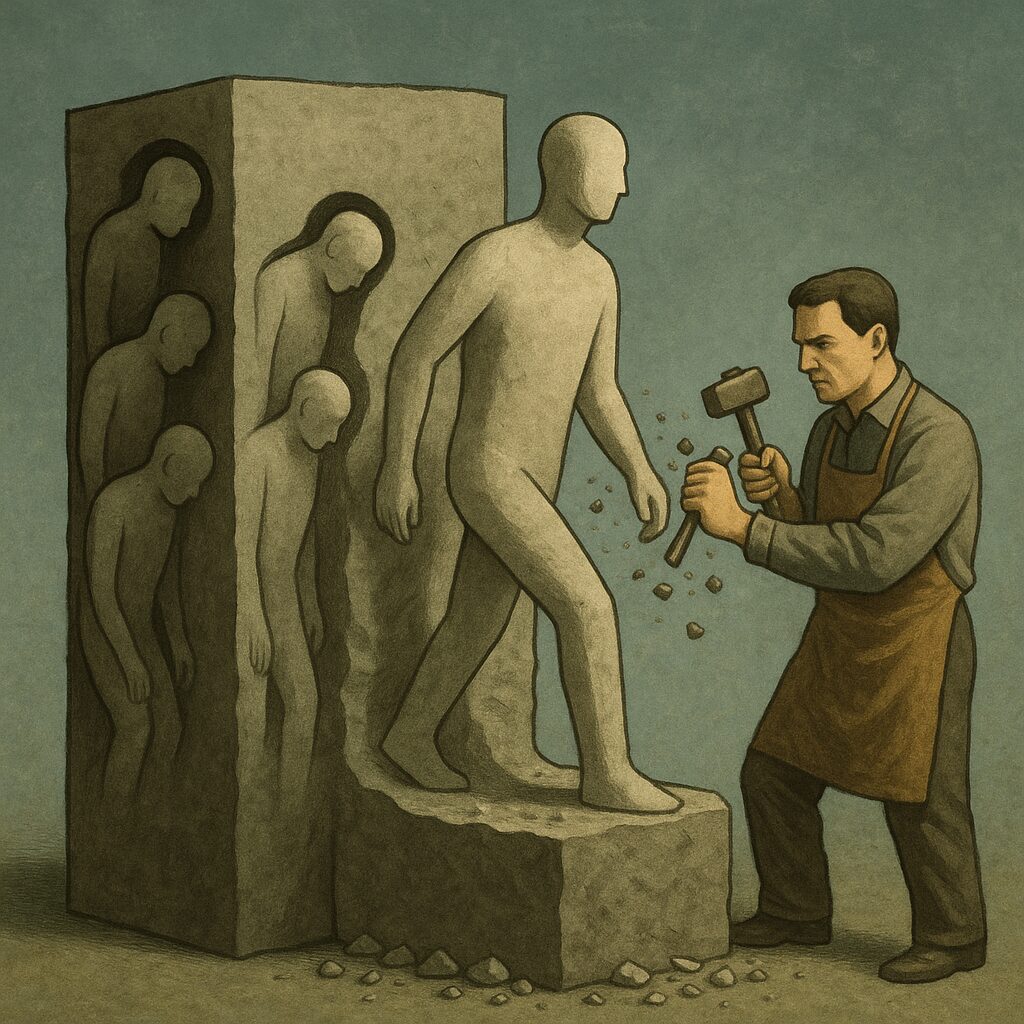

منذ ظهور الذكاء الاصطناعي، كان الإنسان يظن أنه هو من يُعلِّم الآلة. لكن الواقع انقلب رأسًا على عقب: اليوم، الإنسان هو المادة الخام، والخوارزميات هي التي تصوغ منه المستقبل. فكل نقرة، وكل تفاعل، وكل خطأ بشري يتحول إلى بيانات تُغذي النماذج، لتتعلم منها كيف “تفكر” و”تتنبأ” و”تقرر”.

في عالمٍ أصبح السلوك البشري نفسه مادةً أوليةً للتعلم، لم تعد الأخطاء مجرد زلات عابرة، بل أصبحت وقودًا لتطور الأنظمة الذكية. ومع الوقت، صارت النماذج تُعيد إنتاج الواقع بناءً على ما جمعته من أفعالنا، لتولد مستقبلًا قد لا نكون نحن من صممه، بل انعكاسًا رقمياً لأنماطنا وسلوكنا الجمعي.

من الملاحظة إلى التكوين

في بدايات الذكاء الاصطناعي، كان المهندسون يزوّدون النماذج بقواعد ومعارف جاهزة. اليوم، لم تعد النماذج تتعلم بهذه الطريقة؛ بل من خلال المراقبة المستمرة للبشر. تتبع كل تصرف على الإنترنت، وتحلل كل تفاعل لغوي أو بصري، وتستنتج منه قاعدة جديدة.

ما نكتبه في مواقع التواصل، وما نبحث عنه في المحركات، وحتى ما نحذفه، يصبح جزءًا من تدريب النموذج. هذه العملية تجعل الإنسان مصدر المعرفة والخطأ في آنٍ واحد، وتحوّل العالم الرقمي إلى مختبر هائل لتعلّم الخوارزميات من سلوكنا اليومي.

الأخطاء كوقود للتطور

الذكاء الاصطناعي لا يتعلم من النجاح فقط، بل من الفشل أكثر. الأخطاء البشرية، سواء في التفكير أو القرار أو الانفعال، تُعد كنزًا للخوارزميات التي تتغذى عليها لتتحسن.

- حين نكتب تغريدة غاضبة، تتعلم الآلة أن تربط المشاعر بالكلمات.

- حين نرتكب خطأ لغويًا، تُدرك الأنماط النحوية غير المثالية وتتعلم تصحيحها.

- حين نُخطئ في الحكم على معلومة، تسجل الخوارزمية التناقضات بين الحقيقة والزيف لتحسن فهمها للعالم.

هكذا، يتحول الخطأ الإنساني إلى معلومة تدريبية قيّمة تساهم في بناء أنظمة أكثر دقة.

الإنسان كحقل تجارب

لم تعد التجارب العلمية محصورة في المختبرات. الإنترنت نفسه أصبح المختبر الأكبر، حيث تُجرى ملايين “التجارب غير المعلنة” يوميًا.

تختبر المنصات ردود أفعال المستخدمين على تغييرات بسيطة في الأزرار أو الألوان، لتتعلم كيف يتفاعل الدماغ البشري مع المحفزات.

هذه التجارب، رغم بساطتها، تبني اليوم ما يُعرف بـ “علم السلوك الرقمي” الذي يغذي الذكاء الاصطناعي ويجعله أكثر قدرة على التأثير فينا مستقبلًا.

كيف تُعيد النماذج بناء المستقبل؟

حين تجمع النماذج كميات ضخمة من السلوك البشري، فإنها لا تكتفي بالملاحظة، بل تبدأ في إعادة توليف هذا السلوك لتتنبأ بما سيحدث لاحقًا.

- في الاقتصاد، تتنبأ الخوارزميات باتجاهات السوق من أنماط استهلاكنا.

- في السياسة، تُحلل الرأي العام لتتوقع نتائج الانتخابات.

- في الطب، تتعلم من أخطاء التشخيص السابقة لتصمم علاجات أكثر دقة.

النتيجة أن النماذج لم تعد مرآة للماضي، بل أصبحت محركات لتشكيل المستقبل — مستقبلٍ بُني من مجموع قراراتنا الصغيرة والعشوائية.

الأثر الفلسفي

يطرح هذا التحول سؤالًا وجوديًا:

إذا كانت النماذج تتعلم من أخطائنا وتعيد إنتاج العالم بناءً عليها، فهل نحن ما زلنا نتحكم في مصيرنا؟

ربما أصبحنا جزءًا من دورة تعلم لا نهائية، فيها تُغذي أفعالنا الخوارزميات، التي بدورها تُعيد صياغة العالم الذي نعيش فيه. ما نفعله اليوم يُصبح قاعدة بيانات لتوقعات الغد، لتتسع الفجوة بين الإنسان كفاعل والإنسان كمصدر بيانات.

الوجه المشرق

رغم كل ذلك، فإن هذا النموذج من التعلم له مزايا واضحة:

- النماذج تتعلم من أخطاء البشر لتجنبها في المستقبل.

- تُستخدم البيانات لتصميم حلول اجتماعية وصحية أكثر فعالية.

- تُمكّن الحكومات من التنبؤ بالكوارث والأزمات قبل وقوعها.

- تُساعد في تحسين جودة التعليم والخدمات العامة بناءً على السلوك الحقيقي لا الافتراضي.

إنها ثورة معرفية حقيقية تعتمد على تحويل التجربة الإنسانية إلى مادة قابلة للقياس والتحليل.

الوجه المظلم

لكن الوجه المظلم لهذا التحول هو أن الإنسان فقد السيطرة على “كيف” تُستخدم أخطاؤه.

- تُستغل البيانات الشخصية في التسويق أو المراقبة السياسية.

- يُعاد إنتاج السلوك البشري بطرق تكرّس التحيز والتمييز.

- يتحول الإنسان إلى مجرد كائن “قابل للتنبؤ” بلا خصوصية أو غموض.

إنه عصر الشفافية المطلقة الذي قد يُحوّل الحرية إلى معادلة احتمالية.

أمثلة واقعية

- منصة YouTube تستخدم سلوك المشاهدة للتنبؤ بما قد يثير اهتمامك غدًا.

- تطبيقات الصحة النفسية تحلل كتابات المستخدمين لاكتشاف مؤشرات الاكتئاب.

- برامج التوظيف الذكية تتعلم من قرارات الموارد البشرية السابقة — حتى الخاطئة منها — وتعيد إنتاج نفس التحيزات.

هذه الأمثلة تُظهر أن النماذج لا تتعلم دائمًا ما هو “صحيح”، بل ما هو “شائع”، ما يجعلها تعيد إنتاج أخطاء الماضي في شكلٍ رقميٍّ أكثر تأثيرًا.

الخطر الأكبر: إعادة إنتاج الخطأ

عندما تُغذي الأخطاء النماذج، تُصبح احتمالية تكرارها عالية ما لم تُضبط بدقة.

- التحيز ضد فئات معينة.

- تضليل إعلامي قائم على نماذج التفاعل.

- قرارات مؤتمتة تعاقب البشر على بيانات غير دقيقة.

وهكذا، يتحول الذكاء الاصطناعي من أداة تصحيح إلى أداة تكرار محسّن للخطأ.

صورة تعبر عن الإنسان كبيانات خام داخل منظومة رقمية ضخمة

رمزية لاستغلال سلوك الإنسان كمصدر تعلم للأنظمة الذكية

رمزية لفكرة أن الأخطاء هي وقود التطور التقني

س: كيف تُحوّل النماذج سلوك الإنسان إلى معرفة؟

ج: عبر جمع وتحليل البيانات اليومية وتحويلها إلى أنماط تعلم قابلة للتنبؤ.

س: هل يمكن أن تتعلم النماذج من الأخطاء بشكل سلبي؟

ج: نعم، فهي قد تُعيد إنتاج الأخطاء والتحيزات إن لم تُراقب مصادر البيانات جيدًا.

س: هل يشكل هذا التعلّم خطرًا على الخصوصية؟

ج: بالتأكيد، لأن البيانات السلوكية تُستخدم غالبًا دون علم المستخدم الكامل.

س: ما الذي يمكن فعله لتقليل الأثر السلبي؟

ج: تعزيز الشفافية، ووضع ضوابط أخلاقية لاستخدام البيانات البشرية في تدريب الأنظمة الذكية.

الخلاصة

“سلوك الإنسان كمادة خام” ليست مجرد استعارة، بل حقيقة العصر الرقمي. نحن نعيش في زمن تتغذى فيه النماذج على أفعالنا، وتعيد من خلالها بناء العالم الذي نعيش فيه. أخطاؤنا لم تعد تُنسى، بل تُحوَّل إلى خوارزميات تصنع قرارات الغد.

إنه زمن جديد، فيه يتعلم المستقبل من ماضينا الرقمي، وتتحول التجربة البشرية إلى مختبر مستمر لا ينام. وبينما تَعِد هذه العملية بتقدم مذهل، فإنها تُذكّرنا أيضًا بمسؤوليتنا: أن نكون واعين بما نمنحه من بيانات، لأن كل ما نفعله اليوم قد يُعاد إلينا غدًا على هيئة نموذجٍ يتنبأ بنا أكثر مما نفهم أنفسنا.

اقرأ أيضًا: “الذكاء الاصطناعي يتذوق الموسيقى”.. ولكن هل يشعر بها؟