AI بالعربي – متابعات

كلما ازداد اعتماد البشر على الذكاء الاصطناعي في المعرفة، والتوجيه، واتخاذ القرار، برز سؤال يتجاوز التقنية والبرمجة ليصل إلى عمق الفلسفة والأخلاق: كيف نُوائم الذكاء الاصطناعي مع القيم البشرية؟ والأهم من ذلك: من يملك حق تحديد ما هو “الصحيح أخلاقيًا” أصلًا؟

هذا السؤال لا يتعلق فقط بما يجب أن يقوله النموذج أو يمتنع عنه، بل بمن يضع الإطار القيمي الذي يتحرك داخله، ومن يملك سلطة تعريف المقبول والمرفوض في عالم متعدد الثقافات، متغير القيم، ومشحون بالصراعات المعرفية.

Alignment أو المواءمة لم تعد مسألة تقنية ثانوية، بل أصبحت جوهر النقاش العالمي حول مستقبل الذكاء الاصطناعي، وحدود سلطته، وطبيعة العلاقة بين الإنسان والآلة.

ما المقصود بالمواءمة أصلًا؟

Alignment تعني جعل سلوك الذكاء الاصطناعي متسقًا مع القيم، والمصالح، والتوقعات البشرية.

بصيغة أبسط: أن يفعل النموذج ما نريده نحن، لا ما يؤدي إليه الحساب البحت.

لكن هذه البساطة خادعة.

لأن السؤال الحقيقي ليس: كيف نُعلّم النموذج أن يكون “جيدًا”؟

بل: ما معنى “الجيد”؟ ومن يعرّفه؟

القيم ليست معادلات، ولا ثوابت رياضية.

هي نتاج ثقافة، وتاريخ، وسياق اجتماعي، وتجربة إنسانية متغيرة.

من المشكلة التقنية إلى المعضلة الأخلاقية

في بدايات الذكاء الاصطناعي، كان الخوف الأساسي هو الخطأ التقني.

هل النموذج يعمل؟

هل يخطئ؟

هل يتعطل؟

اليوم، الخوف أعمق.

النموذج قد يعمل بكفاءة عالية، لكنه قد يتخذ قرارات تضر بفئات معينة، أو تعكس تحيزات غير مرئية، أو تفرض تصورًا أخلاقيًا أحاديًا.

هنا تتحول Alignment من مسألة “سلامة” إلى مسألة سلطة أخلاقية.

هل توجد أخلاق عالمية يمكن مواءمتها؟

أحد الافتراضات الضمنية في كثير من نقاشات المواءمة هو وجود مجموعة قيم إنسانية مشتركة يمكن الاتفاق عليها.

لكن الواقع أكثر تعقيدًا.

ما يُعد حرية في ثقافة، قد يُعد تهديدًا للنظام في ثقافة أخرى.

وما يُعد صراحة مطلوبة في سياق، قد يُعد إساءة في سياق مختلف.

حتى داخل المجتمع الواحد، تختلف القيم باختلاف الأجيال، والطبقات، والتجارب.

إذا كانت القيم نفسها محل خلاف، فكيف نطلب من نموذج أن يلتزم بها دون أن ينحاز؟

المواءمة مع من؟

سؤال Alignment لا يُطرح في الفراغ.

المواءمة دائمًا تكون مع طرف ما.

هل نُوائم الذكاء الاصطناعي مع قيم المطورين؟

أم مع توقعات المستخدمين؟

أم مع القوانين المحلية؟

أم مع معايير أخلاقية عالمية غير متفق عليها بالكامل؟

كل اختيار من هذه الاختيارات يحمل تحيزًا ضمنيًا، حتى لو بدا محايدًا.

المشكلة ليست في وجود تحيز، بل في من يملكه دون مساءلة.

الشركات بوصفها واضعة القيم

في الواقع العملي، كثير من قرارات المواءمة تُتخذ داخل شركات تقنية كبرى.

هذه الشركات تحدد ما يُعد محتوى مقبولًا، وما يُعد خطرًا، وما يجب تقييده.

لكن هذه الشركات ليست مؤسسات أخلاقية محايدة.

هي كيانات تجارية، تعمل ضمن أطر قانونية وثقافية محددة، ولها مصالح اقتصادية وسمعية.

عندما تُحدَّد القيم الأخلاقية عبر سياسات استخدام داخلية، يتحول Alignment إلى امتداد للحوكمة المؤسسية، لا إجماع إنساني.

الدولة والقانون: أخلاق بالإكراه؟

بديل آخر هو إخضاع المواءمة للقوانين.

لكن القوانين نفسها تختلف من دولة لأخرى، بل قد تتغير داخل الدولة الواحدة.

ما هو قانوني اليوم قد يصبح مرفوضًا غدًا.

وما هو محظور في بلد قد يكون عاديًا في بلد آخر.

إذا وُوائم الذكاء الاصطناعي مع القانون فقط، فهل يصبح أخلاقيًا، أم فقط متوافقًا مع السلطة؟

القانون ينظم السلوك، لكنه لا يعرّف بالضرورة ما هو عادل أو إنساني.

المستخدم: صوت غائب أم شريك حقيقي؟

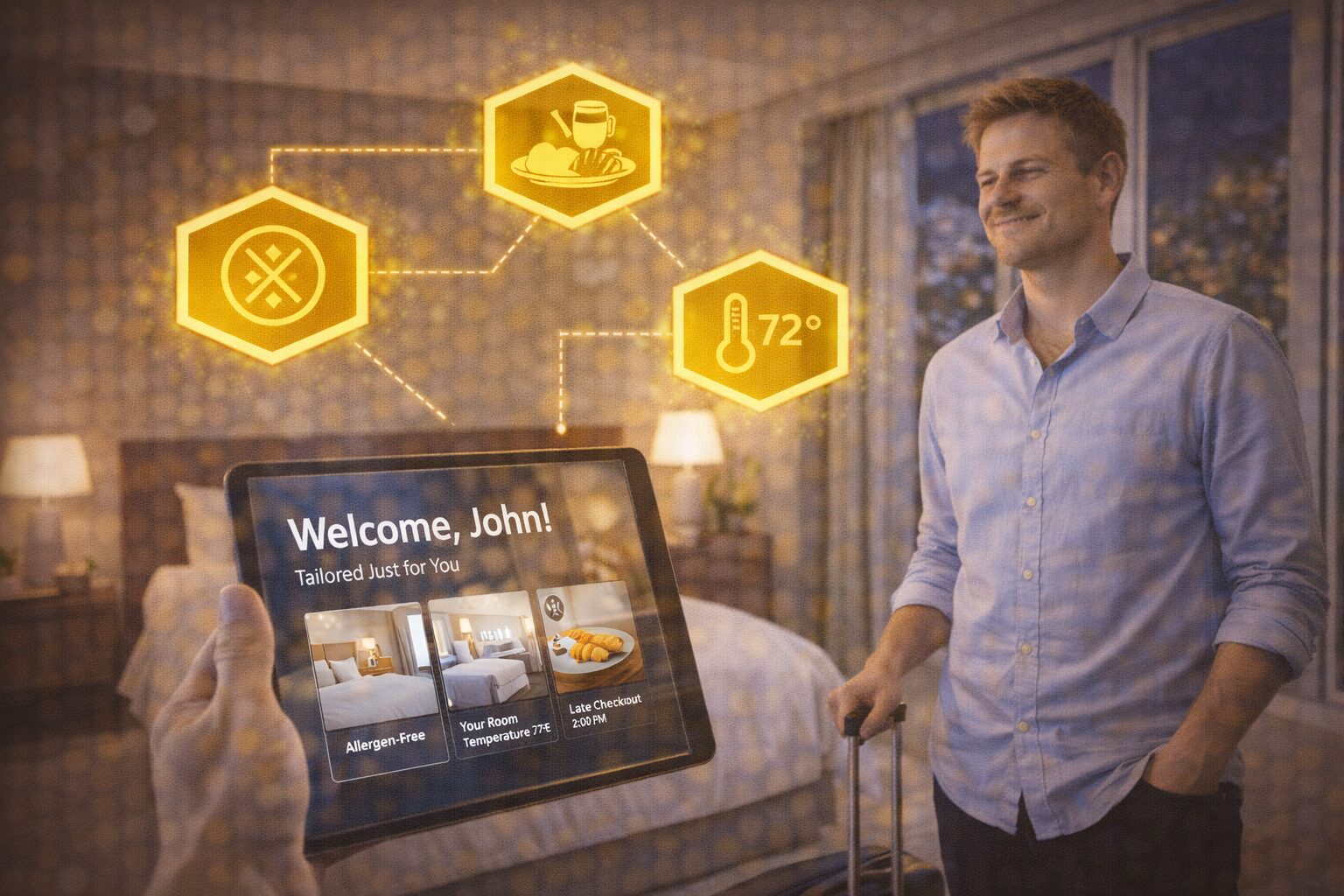

كثيرًا ما يُقال إن المواءمة تهدف لحماية المستخدم.

لكن المستخدم نادرًا ما يشارك فعليًا في تحديد معايير هذه الحماية.

غالبًا ما يُفترض ما يريده المستخدم، بدل سؤاله.

أو يُختزل المستخدم في نموذج افتراضي، لا يعكس التنوع الحقيقي.

Alignment دون مشاركة المستخدمين الفعلية قد تحمي صورة النظام، لا تجربة البشر.

المواءمة والحياد: وهم جذاب

أحد الشعارات الشائعة هو “الحياد”.

أن يكون الذكاء الاصطناعي محايدًا، لا ينحاز، لا يتدخل.

لكن الحياد ذاته اختيار أخلاقي.

والامتناع عن اتخاذ موقف قد يكون موقفًا بحد ذاته.

في قضايا الظلم، أو التمييز، أو المعلومات الخاطئة، قد يصبح الحياد تواطؤًا غير مباشر.

Alignment لا يمكن أن تكون محايدة تمامًا، لأنها تتعامل مع عالم غير محايد.

من يقرر ما الذي يجب منعه؟

جزء كبير من المواءمة يتم عبر المنع.

منع محتوى معين.

منع إجابات محددة.

منع زوايا نقاش حساسة.

لكن المنع لا يكون دائمًا بسبب الخطأ، بل أحيانًا بسبب الخوف من الجدل، أو إساءة الفهم، أو الضغط العام.

عندما يُمنع النقاش بدل توضيحه، تتحول المواءمة إلى إدارة مخاطر، لا توجيه أخلاقي.

الفرق بين الحماية والتوجيه

الحماية تعني منع الضرر الواضح.

أما التوجيه فيعني توجيه التفكير نحو مسار معين.

Alignment تصبح إشكالية عندما تنتقل من حماية المستخدم إلى تشكيل وعيه دون تصريح.

عندما يتعلم النموذج أن يقدّم رؤية معينة للعالم، لا لأنها أدق، بل لأنها “أكثر أمانًا”، نكون أمام سلطة ناعمة لا تُرى.

المواءمة في السياق العربي

في العالم العربي، تتضاعف حساسية سؤال المواءمة.

المنظومة القيمية تختلف عن السياقات الغربية التي تُطوَّر فيها معظم النماذج.

قضايا الدين، والهوية، والأسرة، والسياسة، تُحمل بدلالات مختلفة.

ما يُعد نقاشًا فكريًا في سياق، قد يُعد تعديًا في سياق آخر.

إذا لم تُراعَ هذه الخصوصية، قد ينتج ذكاء اصطناعي “مُوائم عالميًا”، لكنه غريب محليًا.

هل يمكن مواءمة متعددة الطبقات؟

أحد المقترحات هو بناء مواءمة مرنة، تتغير حسب السياق.

مواءمة قانونية حسب الدولة.

مواءمة ثقافية حسب اللغة.

مواءمة أخلاقية حسب نوع الاستخدام.

لكن هذا الحل يفتح بابًا جديدًا:

هل يمكن للنموذج أن يحمل أخلاقًا متعددة دون تناقض؟

أم أننا نطلب منه ارتداء أقنعة مختلفة حسب الطلب؟

المرونة قد تحل مشكلة، لكنها قد تخلق أخرى.

Alignment والشفافية: ما الذي لا يقوله النموذج؟

جزء أساسي من السؤال الأخلاقي هو ما الذي لا يقوله الذكاء الاصطناعي.

الصمت ليس فراغًا، بل قرارًا.

عندما يمتنع النموذج عن الإجابة، أو يخففها، أو يعممها، فهو يطبق مواءمة غير مرئية.

إذا لم يكن المستخدم واعيًا بهذه القيود، فقد يظن أن الصمت يعني عدم وجود معرفة، لا وجود منع.

الشفافية هنا ليست تفصيلًا تقنيًا، بل شرط أخلاقي.

هل يمكن فصل الأخلاق عن التقنية؟

في الواقع، لا.

كل قرار تقني يحمل أثرًا أخلاقيًا، حتى لو لم يُقصد ذلك.

اختيار البيانات.

اختيار المقيمين.

اختيار ما يُكافأ وما يُعاقب.

كلها قرارات قيمية بلباس تقني.

Alignment ليست إضافة أخلاقية على نموذج جاهز، بل جزء من بنيته.

من يحاسب عندما تخطئ المواءمة؟

سؤال نادر الطرح لكنه جوهري.

إذا تسبب الذكاء الاصطناعي في ضرر أخلاقي، من المسؤول؟

المطور؟

الشركة؟

المشرّع؟

أم “النظام” نفسه؟

غياب جهة واضحة للمساءلة يجعل قرارات المواءمة شديدة الخطورة، لأنها بلا ثمن مباشر.

الأخلاق المتغيرة والنماذج الثابتة

القيم تتغير بمرور الوقت.

ما كان مقبولًا قبل عشر سنوات قد لا يكون كذلك اليوم.

لكن النماذج، حتى مع التحديث، تحمل آثار الماضي.

بيانات قديمة.

معايير لم تُراجع.

حساسيات تغيرت.

Alignment ليست حدثًا، بل عملية مستمرة، وإلا تحولت إلى أخلاق متحجرة.

هل يمكن الوصول إلى مواءمة “عادلة”؟

العدالة الكاملة قد تكون هدفًا مثاليًا، لا قابلًا للتحقق.

لكن السعي نحو مواءمة أكثر وعيًا، وأكثر شفافية، وأكثر مشاركة، يظل ممكنًا.

الخطوة الأولى ليست الادعاء بالحياد، بل الاعتراف بالاختيار.

المواءمة بوصفها نقاشًا مجتمعيًا لا قرارًا تقنيًا

أخطر ما يمكن أن يحدث هو اختزال Alignment في فريق تقني مغلق.

المواءمة الأخلاقية يجب أن تكون نقاشًا عامًا، متعدد الأصوات، لا سياسة داخلية.

الذكاء الاصطناعي يؤثر على الجميع، وبالتالي يجب أن يشارك الجميع في تعريف حدوده.

الخلاصة التحليلية

Alignment ليس سؤالًا عن كيفية جعل الذكاء الاصطناعي “جيدًا”، بل سؤالًا عن من يملك تعريف الخير أصلًا.

في عالم متعدد القيم، أي مواءمة هي بالضرورة اختيار، وأي اختيار هو بالضرورة انحياز.

التحدي الحقيقي ليس في إخفاء هذا الانحياز، بل في كشفه، ومناقشته، ومراجعته باستمرار.

في نهاية المطاف، الذكاء الاصطناعي لا يحدد الأخلاق من تلقاء نفسه، لكنه يعكس أخلاق من صمّموه ووجّهوه. والسؤال الذي يجب ألا نتجاهله هو: هل نرضى بأن تُحدَّد القيم الإنسانية في غرف مغلقة، أم نريد أن تكون المواءمة قرارًا إنسانيًا مفتوحًا؟

س: ما المقصود بـ Alignment؟

ج: هو جعل سلوك الذكاء الاصطناعي متوافقًا مع القيم والتوقعات البشرية.

س: لماذا هو إشكالي؟

ج: لأن القيم البشرية نفسها محل خلاف، ولا يوجد تعريف أخلاقي واحد متفق عليه.

س: من يحدد ما هو الصحيح أخلاقيًا؟

ج: حاليًا، غالبًا ما تحدده الشركات والمشرّعون، وليس المجتمع ككل.

س: هل يمكن مواءمة محايدة؟

ج: لا، لأن كل مواءمة تنطوي على اختيار أخلاقي ضمني.

س: ما الحل الأقرب للواقع؟

ج: شفافية أكبر، ومشاركة مجتمعية أوسع، واعتراف بأن المواءمة عملية مستمرة لا قرار نهائي.

اقرأ أيضًا: الذكاء الاصطناعي و”Red Teaming”.. فرق الاختبار العدائي: من يفتش عيوب النموذج قبل الناس؟