AI بالعربي – متابعات

4

لم يعد الذكاء الاصطناعي الحديث يعمل داخل حدود النموذج نفسه فقط، بل أصبح قادرًا على مدّ “أذرع رقمية” نحو أدوات خارجية، وقواعد بيانات، ومحركات بحث، وأنظمة تنفيذ. هذه القدرة تُعرف باسم “Tool Use” أو استخدام الأدوات. وهي من أهم التطورات التي جعلت النماذج اللغوية أكثر عملية في العالم الحقيقي. لكن المفارقة أن هذه الميزة، المصممة لزيادة الدقة، قد تصبح أحيانًا مصدر أخطاء جديدة، تظهر تحت غطاء من الثقة الظاهرية. هنا يبرز سؤال مهم: ماذا يحدث عندما يخطئ النموذج باسم الدقة؟

ما هو مفهوم Tool Use في الذكاء الاصطناعي؟

“Tool Use” يعني أن النموذج لا يعتمد فقط على ما تعلّمه أثناء التدريب، بل يستطيع استدعاء أدوات خارجية للحصول على معلومات أو تنفيذ مهام. قد يستخدم واجهة برمجية للطقس، أو قاعدة بيانات مالية، أو محرك بحث، أو آلة حاسبة، أو نظام حجز. بدل أن يخمّن الإجابة، يحاول الرجوع إلى مصدر مباشر. هذا يجعل الإجابات أقرب للواقع، على الأقل نظريًا.

لماذا ظهرت الحاجة إلى استخدام الأدوات؟

النماذج اللغوية، مهما كانت كبيرة، تظل محدودة بزمن بيانات تدريبها. العالم يتغير بسرعة. الأسعار تتبدل، والقوانين تتحدث، والأحداث تقع يوميًا. لذلك، ظهر اتجاه يربط النماذج بمصادر حيّة. الهدف كان تقليل الهلوسة وزيادة الموثوقية. استخدام الأدوات بدا كجسر بين الذكاء الاصطناعي والعالم الواقعي.

كيف يقرر النموذج استخدام أداة؟

عادة يُدرَّب النموذج على التعرف إلى نوع السؤال. إذا كان السؤال يحتاج حسابًا دقيقًا، قد يستدعي آلة حاسبة. إذا احتاج معلومات حديثة، قد يستدعي محرك بحث. القرار يتم عبر طبقة تخطيط داخلية أو تعليمات مبرمجة. النموذج يقيّم الطلب ثم يختار إن كان سيجيب مباشرة أو سيستخدم أداة.

من النظرية إلى الواقع

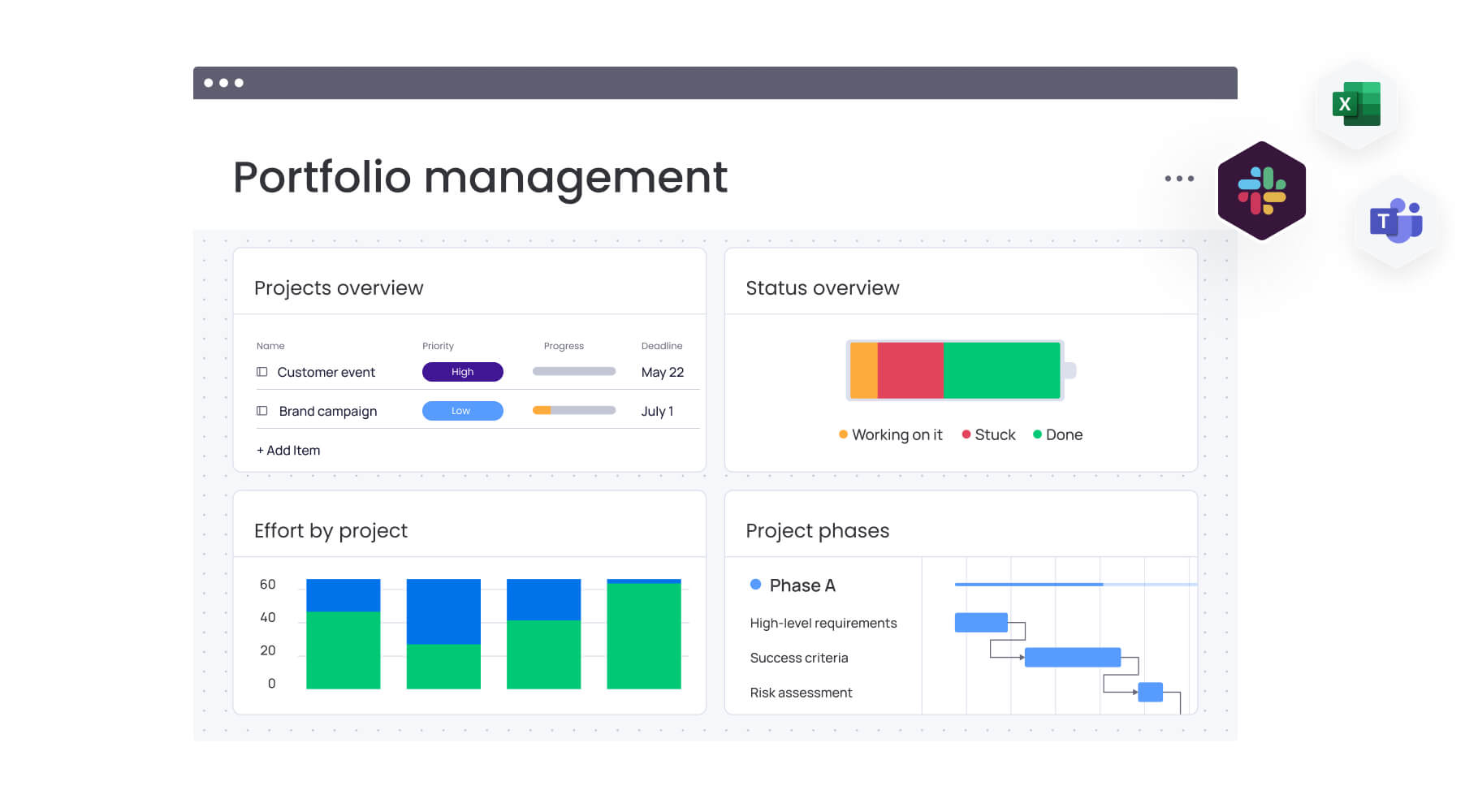

في التطبيقات العملية، أصبح استخدام الأدوات عنصرًا أساسيًا في المساعدين الذكيين، وأنظمة الأعمال، ومنصات خدمة العملاء. بعض الأنظمة لا تجيب أصلًا دون الرجوع إلى أدوات. هذا يعكس انتقال الذكاء الاصطناعي من نموذج نصي إلى نظام تشغيلي متكامل.

أين تبدأ المشكلة؟

المشكلة لا تبدأ عند استخدام الأداة، بل عند الثقة المفرطة في نتائجها. النموذج قد يتعامل مع مخرجات الأداة على أنها حقيقة مطلقة. إذا كانت الأداة نفسها تعطي بيانات ناقصة أو متأخرة، سينقل النموذج الخطأ بثقة عالية. المستخدم يرى إجابة مدعومة بأداة، فيفترض دقتها.

وهم الدقة الرقمية

عندما يقول النموذج إنه استخدم قاعدة بيانات أو أداة رسمية، ترتفع ثقة المستخدم تلقائيًا. لكن هذه الثقة قد تكون مضللة. الأداة قد تحتوي على خطأ، أو يكون الاتصال بها ناقصًا، أو يتم تفسير النتيجة بشكل خاطئ. هنا يصبح الخطأ “مقنعًا” أكثر من الخطأ التخميّني.

أخطاء في استدعاء الأداة نفسها

أحيانًا لا يكون الخطأ في البيانات، بل في طريقة الاستدعاء. النموذج قد يرسل طلبًا بصيغة خاطئة، أو يختار معاملًا غير مناسب. في هذه الحالة، الأداة تعمل كما يجب، لكن المدخلات الخاطئة تقود إلى مخرجات مضللة. النموذج قد لا يدرك ذلك.

سوء تفسير النتائج

حتى إذا أعادت الأداة بيانات صحيحة، يبقى على النموذج تفسيرها. هنا تظهر طبقة جديدة من المخاطر. الأرقام قد تُفهم خارج سياقها. النتائج قد تكون مشروطة بزمن أو مكان. إذا تجاهل النموذج هذا السياق، تتحول الدقة الرقمية إلى خطأ منطقي.

الاعتماد المفرط على الأدوات

كلما زاد اعتماد النظام على أدوات خارجية، زادت نقاط الضعف. انقطاع خدمة واحدة قد يؤثر على سلسلة كاملة من القرارات. النظام يصبح قويًا بقدر أضعف أداة فيه. هذا يطرح تحديات في التصميم والاعتمادية.

هل الأدوات تقلل الهلوسة فعلًا؟

نعم، لكنها لا تلغيها. بدل هلوسة من الذاكرة، قد تظهر هلوسة في تفسير نتائج الأدوات. النموذج قد يملأ فجوات البيانات بتخمينات. أو يربط بين نتائج غير مترابطة. الهلوسة تتغير شكلًا، لكنها لا تختفي تمامًا.

دور التحقق المتقاطع

بعض الأنظمة المتقدمة لا تكتفي بأداة واحدة. قد تستدعي أكثر من مصدر وتقارن بينها. هذا يقلل الأخطاء، لكنه يزيد التعقيد. كما يطرح سؤالًا: ماذا لو اختلفت المصادر؟ أيها يصدق النظام؟

الشفافية مع المستخدم

من أفضل الممارسات أن يُخبر النظام المستخدم متى يستخدم أداة، وما مصدر البيانات، وما حدودها. الشفافية لا تمنع الخطأ، لكنها تساعد المستخدم على التقييم. الغموض قد يخلق ثقة زائفة.

الأمان والخصوصية

استخدام الأدوات يعني تبادل بيانات. أحيانًا بيانات حساسة. إذا لم تُصمَّم الأنظمة بعناية، قد تنتقل معلومات أكثر مما ينبغي. لذلك، يجب ضبط ما يُرسل وما يُستقبل. الخصوصية عنصر أساسي في تصميم Tool Use.

الزمن كعامل خفي

البيانات لها عمر. معلومة كانت صحيحة صباحًا قد تصبح خاطئة مساءً. إذا لم يدرك النموذج توقيت البيانات، قد يقدم معلومة “دقيقة” لكنها منتهية الصلاحية. الزمن عامل حاسم في تقييم الدقة.

التحدي في البيئات الحساسة

في الطب أو المال أو القانون، الخطأ مكلف. هنا لا يكفي استخدام أداة واحدة. يجب وجود طبقات تحقق بشرية. Tool Use في هذه المجالات يحتاج حوكمة صارمة.

من المسؤول عند الخطأ؟

إذا أخطأت الأداة، أم النموذج، أم المطوّر؟ المسؤولية تصبح موزعة. هذا يخلق مناطق قانونية رمادية. لذلك، كثير من المؤسسات تضع تنبيهات وحدود استخدام.

التصميم الجيد لسير الأدوات

الأنظمة الجيدة تضع منطقًا واضحًا: متى تُستخدم الأداة، ومتى يُعتمد على المعرفة الداخلية. التوازن مهم. الاستخدام العشوائي يزيد الأخطاء بدل تقليلها.

التطورات المستقبلية

الاتجاه الحالي نحو أدوات أذكى وتكامل أعمق. سنرى أنظمة تقيّم جودة الأداة نفسها. وربما أنظمة ترفض الإجابة إذا لم تكن واثقة. مفهوم “اللا إجابة” قد يصبح ميزة لا عيبًا.

الثقة المشروطة بدل الثقة المطلقة

المستخدمون بحاجة إلى فهم أن الذكاء الاصطناعي، حتى مع الأدوات، ليس معصومًا. أفضل علاقة هي ثقة مشروطة بالتحقق. التقنية تساعد، لكنها لا تُغني عن التفكير النقدي.

التوازن بين القوة والحذر

Tool Use يمنح الذكاء الاصطناعي قوة عملية كبيرة. لكنه يضيف طبقات من التعقيد. كل طبقة جديدة تعني فرصة جديدة للخطأ. النجاح لا يكمن في كثرة الأدوات، بل في حسن إدارتها.

الصورة الكاملة

استخدام الأدوات خطوة مهمة في تطور الذكاء الاصطناعي من نظام نصي إلى نظام فعّال في العالم. لكنه لا يحوّل النموذج إلى كيان معصوم. الدقة ليست فقط في الوصول إلى البيانات، بل في فهمها وسياقها وحدودها.

خلاصة المشهد

“Tool Use” يعكس نضج الذكاء الاصطناعي وسعيه للتفاعل مع الواقع بدل الاكتفاء بالنصوص. لكنه يذكّرنا أن كل زيادة في القدرة تأتي مع زيادة في المسؤولية. الخطأ باسم الدقة قد يكون أخطر من الخطأ الواضح. لذلك، تبقى الحوكمة، والشفافية، والرقابة البشرية عناصر لا غنى عنها. الذكاء الحقيقي ليس في امتلاك الأدوات، بل في معرفة متى وكيف نستخدمها.

ما هو Tool Use؟

هو قدرة النموذج على استخدام أدوات ومصادر خارجية للحصول على معلومات أو تنفيذ مهام.

هل يجعل ذلك الذكاء الاصطناعي دقيقًا دائمًا؟

لا، يقلل بعض الأخطاء لكنه لا يلغيها.

أين تكمن أكبر المخاطر؟

في الثقة المفرطة في نتائج الأدوات.

كيف يمكن تقليل الأخطاء؟

بالتحقق المتقاطع والرقابة البشرية.

هل يمكن الاستغناء عن البشر؟

لا، خصوصًا في المجالات الحساسة.

اقرأ أيضًا: الذكاء الاصطناعي و”Google AI Mode”.. لماذا تغيّر البحث المحادثي قواعد الظهور في النتائج؟