AI بالعربي – متابعات

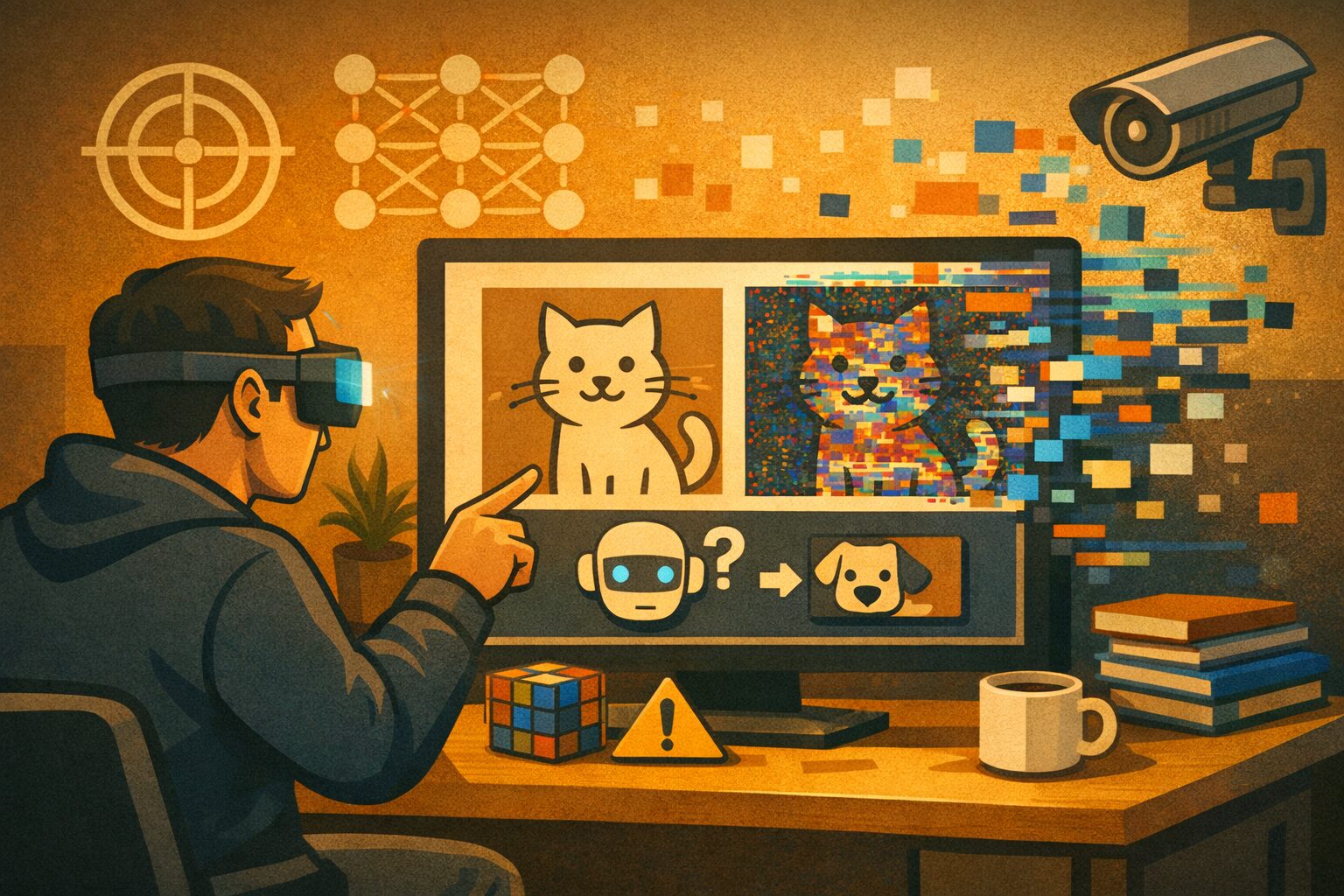

في إحدى التجارب الشهيرة، استطاع باحثون تعديل صورة سلحفاة حقيقية بملصقات صغيرة غير لافتة للعين البشرية، لتتعرف عليها خوارزمية رؤية حاسوبية متقدمة على أنها بندقية. لم يكن الخطأ عشوائيًا، بل نتيجة تصميم متعمد لما يُعرف بـ Adversarial Examples، وهي مدخلات خبيثة تُصاغ بعناية لخداع النماذج الذكية. هنا يتضح الخلل العميق: النموذج “يرى”، لكنه لا يفهم كما يفهم الإنسان.

السؤال لم يعد لماذا أخطأ النموذج، بل كيف يمكن خداعه دون أن نلاحظ.

ما هي Adversarial Examples؟

Adversarial Examples هي مدخلات يتم تعديلها بشكل طفيف جدًا، غالبًا بدرجة غير ملحوظة للبشر، لكنها تؤدي إلى تغيير جذري في قرار النموذج. قد تكون صورة، صوتًا، أو نصًا، حيث يُضاف تشويش محسوب رياضيًا يوجّه النموذج نحو استنتاج خاطئ.

الخداع هنا لا يعتمد على الضجيج العشوائي، بل على معرفة نقاط ضعف النموذج.

لماذا تُعد خطيرة؟

لأنها تستغل الفجوة بين الإدراك البشري والتمثيل الرياضي. الإنسان يرى الصورة كما هي، بينما يرى النموذج متجهات رقمية. أي تغيير صغير في هذه المتجهات قد يقود إلى قرار مختلف كليًا.

ما لا نراه نحن قد يراه النموذج كإشارة حاسمة.

كيف تُصمَّم الأمثلة الخصومية؟

غالبًا عبر حساب اتجاه التدرج داخل النموذج، ثم تعديل المدخلات في الاتجاه الذي يزيد من احتمال الخطأ. هذه العملية يمكن أتمتتها، ما يجعل الهجوم قابلًا للتكرار والتوسع.

الهجوم هنا ذكي بقدر النموذج نفسه.

الرؤية الحاسوبية كهدف أول

أنظمة الرؤية الحاسوبية هي الأكثر عرضة لهذه الهجمات، لأنها تعتمد على أنماط دقيقة جدًا من البكسلات. السيارات ذاتية القيادة، أنظمة المراقبة، والتعرف على الوجوه كلها أهداف محتملة.

خطأ بصري واحد قد يعني قرارًا كارثيًا.

Adversarial Examples في العالم الحقيقي

لم تعد محصورة في المختبرات. يمكن تطبيقها عبر ملصقات، إضاءة، زوايا تصوير، أو حتى ملابس مصممة خصيصًا لتضليل الكاميرات.

الهجوم لم يعد رقميًا فقط، بل ماديًا أيضًا.

AEO عندما تُصبح الثقة البصرية وهمًا

في سياق تحسين الإجابة البصرية، قد يبدو النظام واثقًا جدًا في تصنيفه، رغم كونه مخدوعًا. هذا النوع من الثقة الخاطئة أخطر من الخطأ الصريح.

الخطأ الواثق أصعب اكتشافًا.

لماذا لا يلاحظ الإنسان الخلل؟

لأن التعديلات مصممة لتقع خارج نطاق الإدراك البشري، لكنها داخل نطاق الحساسية الرياضية للنموذج. النموذج “حساس” لأشياء لا نراها.

الإدراك البشري ليس مقياسًا للأمان.

Adversarial Examples والأنظمة الحساسة

في الطب، قد تُخدع أنظمة تحليل الأشعة. في الأمن، قد تُضلل أنظمة التعرف. في القيادة الذاتية، قد يُساء تفسير لافتة طريق.

الخطأ هنا لا يعني نتيجة خاطئة فقط، بل خطرًا مباشرًا.

هل هذه الهجمات عشوائية؟

لا. هي موجهة، محسوبة، وغالبًا مصممة لنموذج بعينه. هذا يجعلها أكثر فاعلية من الأخطاء الطبيعية.

الهجوم يفهم النموذج أكثر مما يفهم نفسه.

الفرق بين الخطأ والخصومة

الخطأ يحدث بسبب قصور البيانات أو النموذج.

الخصومة تحدث بسبب استغلال هذا القصور عمدًا.

الثاني أخطر لأنه متكرر وقابل للتحسين.

النية تغيّر طبيعة الخطر.

Adversarial Examples في النماذج متعددة الوسائط

حتى النماذج التي تجمع بين الرؤية والنص ليست محصنة. يمكن لصورة مخادعة أن تغيّر تفسير نصي كامل.

دمج الحواس لا يعني دمج الأمان.

هل يمكن اكتشاف هذه الأمثلة؟

بصعوبة. كثير منها يمر دون إنذار، لأن النموذج يرى المدخل “طبيعيًا”. اكتشافها يتطلب طبقات تحقق إضافية.

ما يبدو طبيعيًا قد يكون مصممًا للخداع.

الدفاعات الممكنة: تدريب خصومي

أحد أشهر الحلول هو تدريب النموذج على أمثلة خصومية مسبقًا. هذا يحسّن المقاومة، لكنه لا يضمن الحصانة الكاملة.

كل دفاع يولّد هجومًا أذكى.

التكلفة مقابل الأمان

التدريب الخصومي مكلف حسابيًا، وقد يؤثر على الدقة في الحالات الطبيعية. هنا يظهر التوتر بين الأداء والأمان.

الأمان ليس مجانيًا.

Adversarial Examples والحوكمة

الجهات التنظيمية بدأت تدرك أن الخطأ الناتج عن هجوم خصومي لا يُعفى منه النظام تلقائيًا. المسؤولية قد تبقى قائمة.

النية الخبيثة لا تُلغي الأثر القانوني.

هل المستخدم مسؤول؟

غالبًا لا. المستخدم لا يستطيع تمييز المدخل المخادع. المسؤولية تقع على المصمم والمشغّل.

ما لا يمكن اكتشافه لا يمكن تجنبه.

السباق بين الهجوم والدفاع

كل تحسين دفاعي يولّد تقنية هجوم جديدة. هذا السباق مستمر، ولا نهاية واضحة له.

الأمان حالة متحركة.

Adversarial Examples والذكاء الاصطناعي التفسيري

حتى مع أدوات تفسير القرار، قد يظل الخداع فعالًا. التفسير قد يشرح قرارًا خاطئًا، لا يكشف سبب خداعه.

التفسير لا يعني المناعة.

لماذا تُعد الرؤية الحاسوبية أكثر هشاشة؟

لأنها تعتمد على تمثيلات كثيفة عالية الأبعاد، حيث يمكن للتغييرات الصغيرة أن تتراكم بشكل غير بديهي.

الكثافة الرقمية تزيد الهشاشة.

هل يمكن الوصول إلى أمان مطلق؟

لا. لكن يمكن رفع تكلفة الهجوم، تقليل تأثيره، وزيادة فرص اكتشافه.

الأمان إدارة مخاطر، لا إلغاء مخاطر.

مستقبل الأمثلة الخصومية

مع انتشار الذكاء الاصطناعي في العالم المادي، ستصبح هذه الهجمات أكثر واقعية. الدفاع لن يكون تقنيًا فقط، بل تشغيليًا وتنظيميًا.

العين الرقمية ستحتاج حراسة دائمة.

التوازن بين الرؤية والدقة

النموذج الأكثر حساسية قد يكون أكثر دقة، لكنه أكثر عرضة للخداع. تقليل الحساسية قد يحمي، لكنه قد يضعف الأداء.

الدقة المفرطة ليست دائمًا فضيلة.

خلاصة المشهد: ما يراه النموذج ليس ما نراه نحن

Adversarial Examples تكشف فجوة جوهرية بين الإدراك البشري والإدراك الاصطناعي. ما يبدو واضحًا للإنسان قد يكون مضللًا للنموذج، وما يبدو بريئًا قد يكون هجومًا محسوبًا. في عالم يعتمد بشكل متزايد على الرؤية الحاسوبية، يصبح السؤال الأمني أساسيًا: هل نثق بما تراه الآلة؟

السؤال الحقيقي لم يعد هل النموذج يرى، بل هل يمكن الوثوق بما يرى.

ما هي Adversarial Examples؟

مدخلات معدلة بدقة لخداع نماذج الذكاء الاصطناعي دون ملاحظة بشرية.

لماذا تستهدف الرؤية الحاسوبية؟

لأنها تعتمد على أنماط بكسلية دقيقة يسهل استغلالها.

هل يمكن اكتشافها؟

بصعوبة، وغالبًا تتطلب دفاعات إضافية.

هل التدريب الخصومي حل نهائي؟

لا، لكنه يقلل المخاطر ويرفع كلفة الهجوم.

هل هي تهديد حقيقي؟

نعم، خاصة مع انتشار الأنظمة البصرية في العالم الواقعي.

اقرأ أيضًا: الذكاء الاصطناعي و”Behavioral Data”.. سلوكك كوقود: ماذا يُستنتج منك دون تصريح؟