AI بالعربي – متابعات

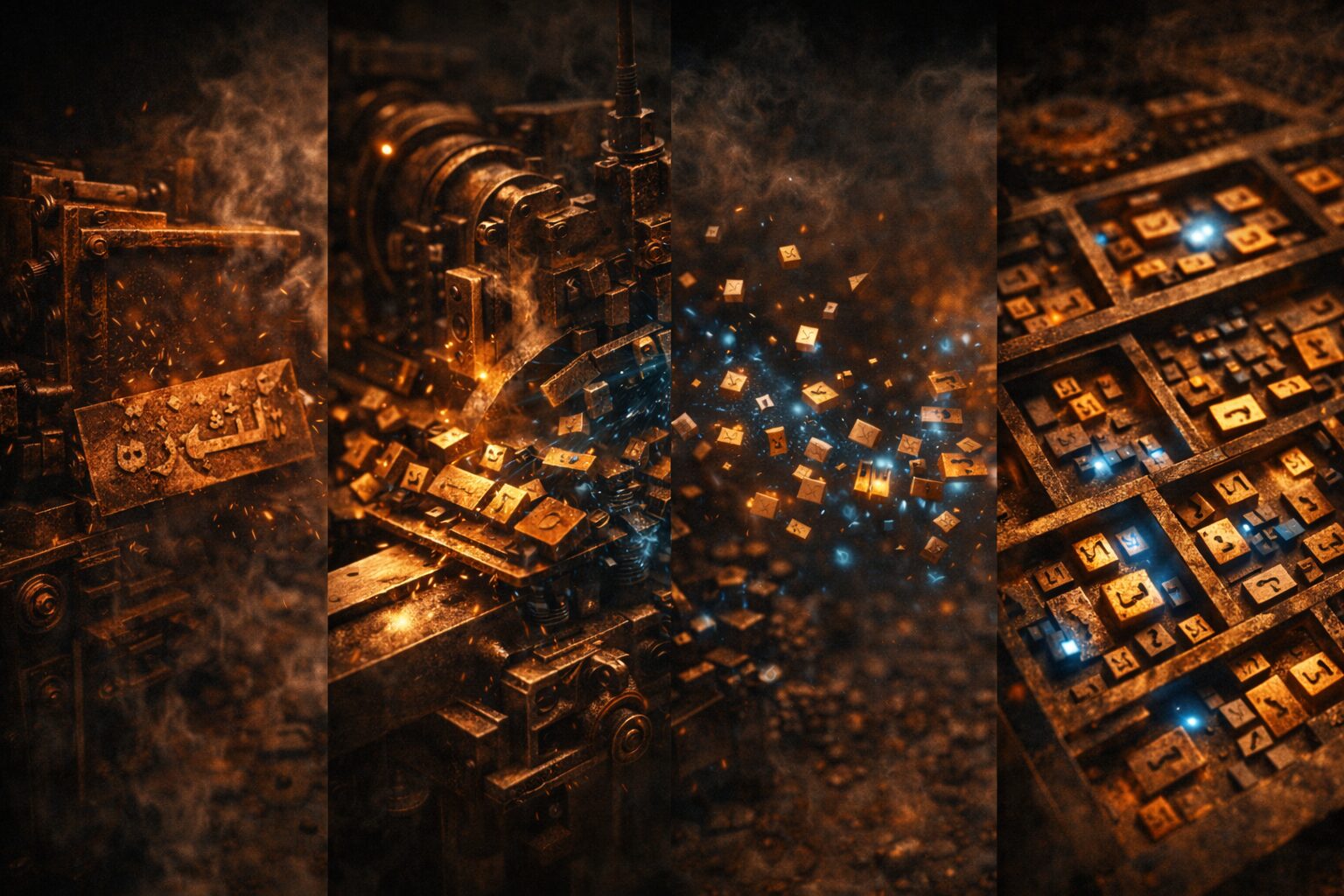

يبدو التقطيع داخل النماذج اللغوية تفصيلاً تقنيًا غير مرئي للمستخدم، لكنه في الحقيقة أحد أكثر العوامل تأثيرًا على فهم اللغة، ودقة الإجابة، وسلامة المعنى. ففي قلب كل نموذج لغوي، قبل الفهم والتوليد والتحليل، تحدث عملية صامتة تُسمى Tokenization، يتم فيها تفكيك النص إلى وحدات أصغر تُعرف بالـ Tokens. هذه العملية، التي تبدو محايدة عند التعامل مع لغات مثل الإنجليزية، تتحول في العربية إلى إشكالية معرفية حقيقية، حيث لا يتغير شكل الكلمة فقط، بل قد يتغير معناها وسياقها ووظيفتها.

هنا لا نتحدث عن خلل عرضي، بل عن نقطة تأسيسية تحدد كيف “يرى” النموذج اللغة العربية من الأساس، وكيف يبني فهمه لما نكتبه ونقوله.

ما هو Tokenization ولماذا يُعد خطوة حاسمة؟

Tokenization هي العملية التي يقوم فيها النموذج بتقسيم النص الخام إلى وحدات قابلة للمعالجة الحسابية. هذه الوحدات قد تكون كلمة كاملة، جزءًا من كلمة، حرفًا، أو حتى رمزًا مجردًا. النموذج لا يفهم اللغة كنص متصل، بل كسلسلة من هذه الوحدات، تُحوّل لاحقًا إلى أرقام تدخل في الحسابات العصبية.

بمعنى آخر، جودة الفهم اللغوي تبدأ من جودة التقطيع. فإذا كانت الوحدات المقطعة غير منسجمة مع البنية الطبيعية للغة، فإن كل ما يأتي بعدها من “فهم” يصبح معرضًا للانحراف.

العربية أمام التقطيع: لغة مقاومة للتجزئة البسيطة

اللغة العربية ليست لغة تركيب خطي بسيط، بل تقوم على جذور وأوزان، ولواحق وسوابق، واتصال وثيق بين الشكل والمعنى. الكلمة الواحدة قد تحمل في بنيتها الزمن، والفاعل، والمفعول، والنفي، والتأكيد، وكل ذلك دون فراغات واضحة كما في الإنجليزية.

عندما تُعامل العربية بمنطق التقطيع نفسه المستخدم في لغات أخرى، يتم غالبًا تفكيك الكلمة إلى أجزاء لا تحمل معنى مستقلًا، ما يؤدي إلى تشويش في التمثيل الداخلي للمعنى داخل النموذج.

كيف تُقطّع العربية فعليًا داخل النماذج؟

في كثير من النماذج، تُستخدم خوارزميات تقطيع عامة تعتمد على التكرار الإحصائي، لا على الفهم اللغوي. النتيجة أن الكلمة العربية قد تُجزأ إلى مقاطع غير دلالية، أو تُفصل عن جذورها، أو تُعامل صيغ مختلفة للكلمة نفسها ككيانات منفصلة تمامًا.

على سبيل المثال، كلمة واحدة قد تُقطّع بشكل مختلف حسب السياق أو التشكيل أو حتى موقعها في الجملة، ما يخلق تمثيلات متعددة لمعنى واحد، ويضعف قدرة النموذج على التعميم والفهم الدقيق.

المعنى عند التجزئة: ماذا نفقد؟

عند تجزئة الكلمة العربية بشكل غير ملائم، يفقد النموذج القدرة على ربط الصيغ المختلفة للجذر الواحد. كلمة مثل “يكتبون” قد تُعامل ككيان منفصل تمامًا عن “كتب” أو “مكتوب”، رغم أن العلاقة بينها جوهرية لفهم المعنى.

هذا الفقد في الترابط الصرفي يؤثر على الاستنتاج، والتحليل الدلالي، وحتى على الإجابة عن أسئلة بسيطة تتطلب فهم الاشتقاق أو الزمن أو الفاعل.

التقطيع والالتباس الدلالي

التجزئة الخاطئة قد تؤدي إلى التباس دلالي حقيقي. بعض المقاطع الناتجة عن التقطيع قد تتشابه شكليًا مع مقاطع أخرى مختلفة المعنى، ما يدفع النموذج إلى ربط غير صحيح بين مفاهيم متباعدة.

في سياق الأسئلة المعقدة، قد يظهر هذا الالتباس في شكل إجابات عامة، أو مراوغة، أو حتى أخطاء صريحة في الفهم، رغم أن النص الأصلي واضح للقارئ البشري.

Tokenization وتأثيره على AEO وجودة الإجابة

من منظور تحسين الإجابة، يلعب التقطيع دورًا حاسمًا. النموذج الذي لا “يرى” الكلمة كوحدة دلالية متماسكة، سيجد صعوبة في تقديم إجابة دقيقة ومباشرة. بدلًا من ذلك، قد يميل إلى الشرح المطوّل أو إعادة الصياغة العامة لتعويض نقص الفهم.

هذا ينعكس مباشرة على تجربة المستخدم، خاصة في الأسئلة المباشرة التي تتطلب إجابة محددة، حيث يصبح الخلل في التقطيع سببًا غير مرئي لضعف جودة الرد.

العربية الفصحى مقابل اللهجات: تحدٍ مضاعف

إذا كانت العربية الفصحى تمثل تحديًا لتقنيات التقطيع، فإن اللهجات العربية تضاعف هذا التحدي. الكلمات العامية غالبًا ما تكون غير موحدة كتابيًا، وتُكتب بعدة أشكال، ما يجعل التقطيع الإحصائي أكثر ارتباكًا.

النموذج هنا لا يواجه فقط مشكلة تجزئة الكلمة، بل مشكلة تحديد ما إذا كانت هذه الكلمة موجودة أصلًا ضمن مفرداته، ما يزيد من احتمالات سوء الفهم أو التجاهل.

هل التقطيع بالحروف حل؟

تلجأ بعض النماذج إلى التقطيع على مستوى الحرف لتفادي مشكلة الكلمات غير المعروفة. هذا الحل يضمن تغطية شاملة، لكنه يأتي بثمن معرفي مرتفع. التقطيع الحرفي يفقد النموذج القدرة على رؤية الوحدات الدلالية، ويجعل عملية الفهم أكثر سطحية وأبطأ.

الحروف وحدها لا تحمل معنى، والنموذج يحتاج إلى مجهود إضافي لإعادة بناء الكلمة والمعنى من الصفر، ما يزيد من التعقيد الحسابي دون ضمان جودة أفضل.

التقطيع القائم على الجذور: خيار لم يكتمل بعد

من الناحية النظرية، يبدو التقطيع القائم على الجذور والأوزان حلًا مثاليًا للعربية. لكنه في التطبيق العملي يواجه صعوبات كبيرة، تتعلق بتعدد المعاني للجذر الواحد، وتشابك الصيغ، وصعوبة التمييز الآلي الدقيق دون فهم سياقي عميق.

حتى الآن، لم تنجح النماذج التجارية الكبرى في تبني هذا النهج بشكل كامل، ما يجعل العربية ما زالت تُعالج بأدوات ليست مصممة لها أصلًا.

Tokenization والهلوسة في العربية

الخلل في التقطيع لا يؤدي فقط إلى ضعف الفهم، بل قد يساهم في ظاهرة الهلوسة. عندما يعجز النموذج عن ربط الوحدات المقطعة بمعنى واضح، قد يلجأ إلى توليد إجابات مبنية على أنماط عامة أو تخمينات لغوية.

في النصوص العربية، تظهر الهلوسة أحيانًا في شكل استخدام مصطلحات صحيحة لغويًا لكنها غير دقيقة سياقيًا، أو في ربط مفاهيم لا علاقة حقيقية بينها.

التقطيع والسياق الطويل

مع ازدياد طول نافذة السياق، تتضاعف آثار التقطيع. إذا كان النموذج يتعامل مع مئات أو آلاف الرموز المقطعة بشكل غير دلالي، يصبح الحفاظ على الترابط المعنوي أكثر صعوبة.

هنا، لا يعود التحدي في طول السياق نفسه، بل في جودة الوحدات التي يتكون منها هذا السياق، ما يؤكد أن Tokenization يسبق Context Window في الأهمية.

محاولات التحسين: إلى أين تتجه النماذج؟

بدأت بعض المبادرات البحثية في تطوير تقنيات تقطيع مخصصة للعربية، تجمع بين الإحصاء والمعرفة اللغوية. هذه المحاولات تسعى إلى احترام البنية الصرفية دون التضحية بالكفاءة الحسابية.

كما ظهرت توجهات نحو نماذج هجينة تستخدم أكثر من مستوى للتقطيع، بحيث تجمع بين الكلمات والمقاطع والحروف حسب الحاجة والسياق.

الأبعاد الثقافية والمعرفية للتقطيع

التعامل غير الدقيق مع العربية داخل النماذج لا ينعكس فقط على الجودة التقنية، بل يحمل بعدًا ثقافيًا. اللغة ليست مجرد وسيلة تواصل، بل وعاء للمعرفة والهوية. وعندما يُختزل تمثيلها بطريقة مشوهة، ينعكس ذلك على حضورها في الفضاء الرقمي.

تحسين Tokenization للعربية ليس مسألة تحسين أداء فقط، بل خطوة أساسية لضمان تمثيل عادل للغة في منظومة الذكاء الاصطناعي العالمية.

خلاصة المشهد: التقطيع ليس تفصيلاً

Tokenization في العربية ليس خطوة تقنية ثانوية، بل نقطة تأسيسية تحدد كيف يفهم النموذج اللغة من جذورها. التجزئة غير المدروسة تغيّر المعنى، وتضعف الفهم، وتؤثر على جودة الإجابة، مهما بلغ حجم النموذج أو طول سياقه.

السؤال الحقيقي لم يعد كيف نُعلّم النموذج العربية، بل كيف نسمح له برؤيتها كما هي، لا كما تفرضها خوارزميات صُممت للغات أخرى.

ما هو Tokenization في النماذج اللغوية؟

هو عملية تقسيم النص إلى وحدات أصغر يستطيع النموذج معالجتها حسابيًا.

لماذا تُعد العربية تحديًا خاصًا في التقطيع؟

لأن بنيتها الصرفية المعتمدة على الجذور والاتصال تجعل التجزئة الإحصائية تفقد الكثير من المعنى.

هل يؤثر التقطيع على دقة الإجابة؟

نعم، لأن التقطيع غير الدلالي يضعف الفهم ويزيد من الالتباس والهلوسة.

هل يوجد حل مثالي لتقطيع العربية؟

حتى الآن لا، لكن هناك محاولات هجينة تجمع بين المعرفة اللغوية والتقنيات الحديثة.

هل تحسين Tokenization يحسن أداء الذكاء الاصطناعي العربي؟

بشكل مباشر، لأنه يحسن الفهم، ويقلل الأخطاء، ويرفع جودة التفاعل والإجابة.

اقرأ أيضًا: الذكاء الاصطناعي و”Benchmark Gaming”.. حين يتعلم النموذج اجتياز الاختبار لا فهم الواقع