AI بالعربي – متابعات

الحديث عن أخطار الذكاء الاصطناعي وتهديداته للبشرية وما تتضمنه من مخاوف تتعلق بسيطرة الآلات، ليس وليد مرحلة ما بعد “شات جي بي تي”، بل يعود إلى سنوات عدة مضت، لكن الفرق أن الأصوات اليوم أصبحت أعلى وأكثر انتشاراً، كما انضمت إليها أسماء بارزة في المجال ذاته ورجال أعمال وشخصيات أسهمت بشكل أساس في تطويره وإيصاله لما هو عليه.

وانتشرت عبارة الأخطار الوجودية وأصبح يطلق عليها اصطلاحاً (x-risk) لتعتبر واحدة من أكبر التهديدات التي تواجه البشرية، لكن ما المقصود بالضبط بالخطر الوجودي؟ وما هو منطلق الافتراضات التي تحذر من أن يشكل الذكاء الاصطناعي خطراً وجودياً؟

تهديدات من صنع الإنسان

على مدى معظم تاريخ البشرية، كان المصدر الوحيد للتهديدات أو الـx-risk التي يمكن أن تواجه البشرية يتعلق بأسباب طبيعية مثل اصطدام كويكب بالأرض أو جائحة عالمية مثلاً، لكن إنشاء أول قنبلة ذرية عام 1945 قدم مصدراً جديداً كلياً للتهديد الوجودي للبشرية، مصدر يمكن وصفه بأنه بشري بطبيعته، ومنذ ذلك الحين، خلقت البشرية أنواعاً عدة أخرى من التهديدات بما في ذلك تغير المناخ وفقدان التنوع البيولوجي العالمي والحروب البيولوجية وصولاً إلى تهديدات الذكاء الاصطناعي.

وبات يُعتقد على نطاق واسع أن معظم التهديدات الوجودية اليوم هي من صنع الإنسان ونتيجة لهذه التهديدات الجديدة يمكن اعتبار القرن الحالي أخطر قرن واجهته البشرية على الإطلاق، واليوم اعتماداً على الكيفية التي تتطور التكنولوجيا من خلالها يمكن أن يشكل الذكاء الاصطناعي خطراً مباشراً أو غير مباشر، على رغم أن العلماء يرجحون الكفة للخطر غير المباشر.

لكن متى ظهرت هذه المخاوف وما هي محرضات ظهورها؟

من الخيال العلمي إلى عقول العلماء

انطلقت هذه المخاوف للمرة الأولى من عالم الأدب والخيال العلمي، إذ لمح الكاتب والروائي صموئيل بتلر عام 1863 إلى أن الآلات قد تهيمن يوماً ما على العالم وسكانه، ثم ما لبثت أن طرقت أبواب مفكرين أمثال آلان تورينغ الذي دعا الناس إلى ترقب يوم ستتمكن فيه الآلات الذكية من السيطرة في نهاية الأمر، إضافة إلى عدد كبير من الأفلام التي كرست فكرة استيلاء الذكاء الاصطناعي وهيمنته على العالم.

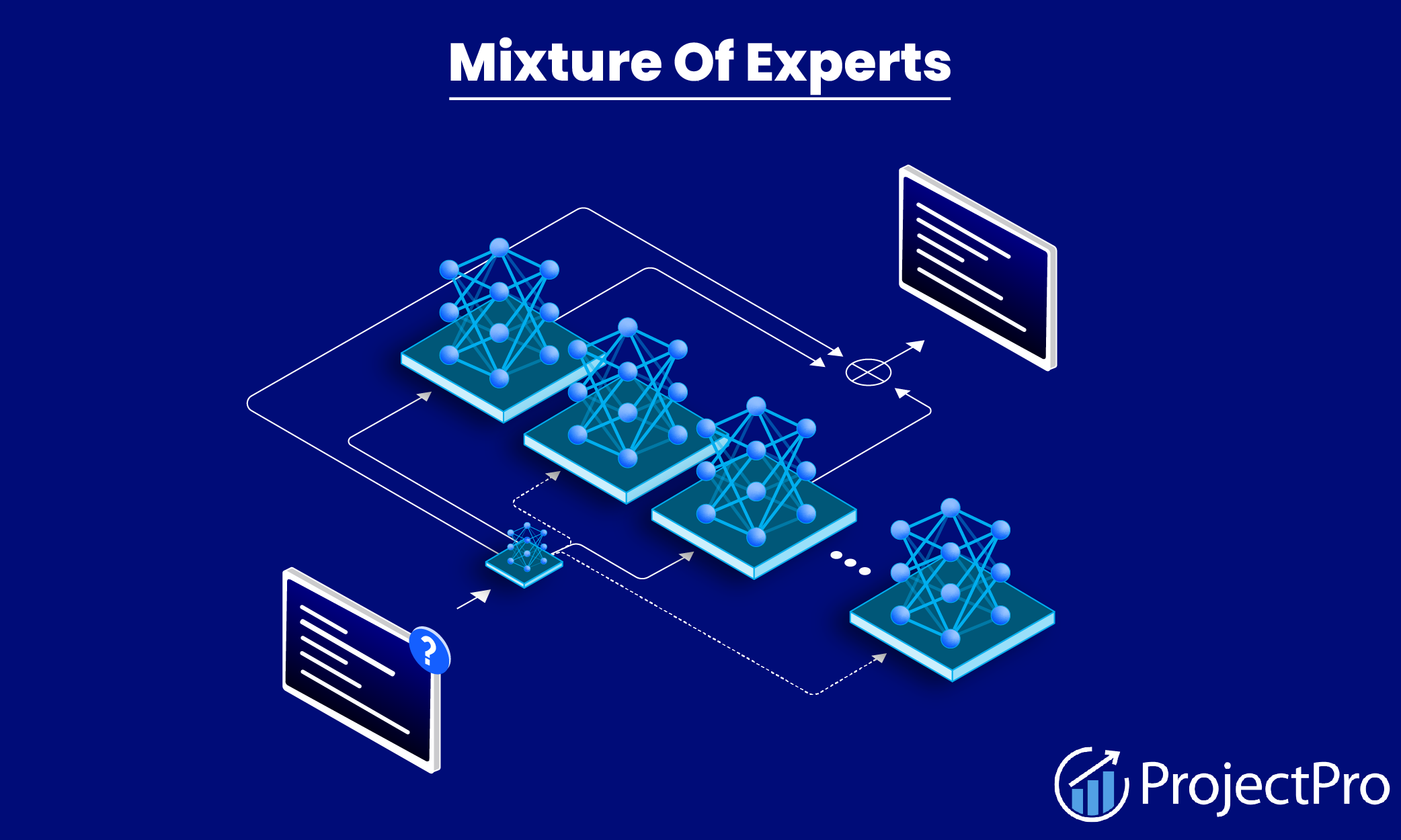

ومع الوقت ازداد عدد المحذرين من الأكاديميين، لكن الاهتمام المتجدد في هذه الفترة جاء في جزء منه مدفوعاً بثورة التعلم العميق الأخيرة، وما تضمنتها من تطور في الشبكات العصبية الاصطناعية، بما في ذلك التعرف إلى الكلام والوجه وإنشاء الصور والألعاب، إضافة إلى سرعة التقدم التي تحرزها هذه الأنظمة وتوقعات ما سيؤول إليه الوضع في المستقبل وما يمكن أن تشكله من تهديد وجودي إذا لم تكن إدارتها تتم بشكل صحيح.

مفهوم الخطر الوجودي

يفهم من عبارة الخطر الوجودي أنه الأخطار التي يمكن أن تتسبب إما بشكل مباشر في انقراض الجنس البشري أو أن تؤدي بشكل أقل مباشرة إلى ظروف تسبب الانقراض، وفي عام 2002 قدم مصطلح “الخطر الوجودي” من قبل الفيلسوف في جامعة أكسفورد نيك بوستروم، الذي اشتهر بعمله على المبدأ الأنثروبي (الإنساني الوجودي) ودراسة الأخطار الوجودية وأخطار الذكاء الفائق، من خلال ورقته البحثية ” الأخطار الوجودية: تحليل سيناريوهات انقراض الإنسان والأخطار ذات الصلة”، وعرف بوستروم الخطر الوجودي بأنه واحد من النتائج العكسية التي يمكن أن تؤدي إلى إبادة الحياة الذكية التي نشأت على الأرض أو تقليص إمكاناتها واحتمال وجودها بشكل دائم وجذري، أما مصطلح الذكاء الخارق فيمثل بحسب تعريفه أي فكر يتجاوز بدرجة كبيرة الأداء المعرفي للبشر.

وفي حين أن هناك أرضية مشتركة بين العلماء حول سيناريوهات الخطر الوجودي، إلا أن كارينا فولد، فيلسوفة العلوم المعرفية والذكاء الاصطناعي والأستاذة المساعدة في معهد التاريخ بجامعة تورنتو، تجد أنه لا يوجد تعريف دقيق لهذا المفهوم، بل إنه لا يزال هناك خلاف كبير حول كل من طبيعة واحتمالية التهديدات الوجودية التي يشكلها الذكاء الاصطناعي.

تهديدات عرضية وهيكلية

وفي بحث بعنوان “كيف يشكل الذكاء الاصطناعي أخطاراً وجودية؟”، تذكر فولد طريقة مساعدة أوجدها العلماء للتفكير في أخطار الذكاء الاصطناعي عبر تقسيمها إلى أخطار عرضية وهي التهديدات الناشئة عن تصرف النظام بطرق غير مقصودة، وأخطار هيكلية أو أخطار إساءة الاستخدام وتمثلها التهديدات الناشئة عن كيفية تشكيل التكنولوجيا للبيئة الأوسع، بخاصة في المجالين السياسي والعسكري، بطرق يمكن أن تزيد من الأخطار.

وقدمت فولد الحجج الرئيسة التي يستند إليها الاعتقاد بالخطر الوجودي للذكاء الاصطناعي، كما بينت نقاط الخلاف والضعف فيها، إذ تتعلق الحجة الأولى بالتحكم، وتحذر بأن الذكاء الاصطناعي قد يصبح قوياً وغير مبال بالقيم الإنسانية، الأمر الذي سيؤدي إلى عواقب وخيمة على البشر، وعلى رغم كونها حجة طويلة الأمد إلا أنها تستند إلى أطروحات واضحة بالنسبة للعلماء.

وكذلك ترتبط الحجة الثانية بفقدان تحكم البشر بعد ظهور ذكاء اصطناعي ذي استراتيجية يسيطر على الأرض ويتحكم بالبشر ويسحب أدوات التحكم منهم، أما الحجج الحديثة فتركزت بغالبيتها على مجموعة من القضايا الأكثر إلحاحاً والمبنية على أسس علمية، وأحد هذه الأسباب هو القلق المتزايد من أن الذكاء الاصطناعي المتقدم يمكن أن يمنح مزايا استراتيجية كبيرة لمالكيه، وما إذا كان من الممكن أن ينشأ سباق بين الجهات الفاعلة القوية في السعي وراء هذه التكنولوجيا، أو إشعال صراع عسكري بين المتنافسين، ترافقه قضية ذات صلة تتعلق بالتأثير الذي يمكن أن يحدثه الذكاء الاصطناعي على الاستقرار الاستراتيجي العالمي.

إساءة استخدام محتملة

وتركز فولد في المخاطر العرضية بشكل أساس على سيناريو افتراض عدم وجود أي شخص معني يرغب في إحداث ضرر، بل إن مجرد بناء نظام ذكاء اصطناعي متقدم يخلق تهديدات، لكن هذا لا يعني أيضاً الاستبعاد التام لاحتمالية إساءة استخدام الذكاء الاصطناعي عن عمد، والتي يمكن أن تحدث عن طريق استغلال نقاط الضعف في البرامج والقيام بالقرصنة الآلية أو توليد الخلافات السياسية أو نشر المعلومات المضللة باستخدام وسائل إعلام مصطنعة أو شن هجمات حقيقية باستخدام إما طائرات من دون طيار أو أسلحة آلية.

وهنا تجادل فولد بأن الأمر لا يتطلب كثيراً من الإبداع لتخيل سيناريوهات يمكن أن يشكل فيها نظام الذكاء الاصطناعي تهديداً وجودياً حقيقياً في حال وصل إلى الأيادي الخطأ، مثل أن يوجهه أحدهم لامتصاص كل الأوكسجين الموجود في الهواء أو لإطلاق جميع الأسلحة النووية في ترسانة الدولة أو لابتكار فيروس بيولوجي قاتل محمول بالهواء، أو ربما لاختراق البنى التحتية الحيوية مثل تلك التي تدير مشاريع واسعة النطاق مثل الأقمار الاصطناعية التي تدور حول الأرض.